Меня зовут Владимир Аксёнов, я работаю в Yandex Infrastructure и руковожу IT‑поддержкой в том самом дата‑центре Яндекса, который стал первой площадкой в собственности компании. Это определило его судьбу первопроходца: именно здесь мы тестируем множество технологий, которые затем распространяются на другие дата‑центры. За 13 лет на этой площадке мы наблюдали радикальные изменения форм‑фактора сетевого и серверного оборудования, что повлекло за собой серьёзные метаморфозы во всём дата‑центре. Мы прошли путь от стандартной 19-дюймовой стойки до четвёртого поколения стоек собственного дизайна, а от холодных коридоров с доохлаждением — пришли к энергоэффективному фрикулингу. В этой статье покажу, как за это время поменялось IT‑оборудование, как это повлияло на облик дата‑центров, и что интересного ждём в наших дата‑центрах в 2026 году. 2012: построили свой дата-центр!  Наша первая собственная площадка была построена в бывших помещениях станкостроительного завода. На тот момент это было оптимальное решение: есть надёжный источник питания, который даст электричество в нужном количестве, есть подвод природного газа, а в просторных помещениях можно строить машинные залы круглый год, невзирая на погодные условия. Сначала здесь появился минимальный набор IT‑инфраструктуры для запуска: NOC‑room и два первых кластера. Туда мы устанавливали оборудование, которое зарекомендовало себя и на предыдущих площадках: серверы и дисковые полки в стойки 19". Чтобы поддерживать нужную температуру в кластерах, было необходимо охлаждение. С инженерной точки зрения, существующая на тот момент схема кондиционирования использовала доохлаждение — для получения холода требовалась дополнительная энергия. Поэтому был запущен Центр холодоснабжения с абсорбционными холодильными машинами:

Наша первая собственная площадка была построена в бывших помещениях станкостроительного завода. На тот момент это было оптимальное решение: есть надёжный источник питания, который даст электричество в нужном количестве, есть подвод природного газа, а в просторных помещениях можно строить машинные залы круглый год, невзирая на погодные условия. Сначала здесь появился минимальный набор IT‑инфраструктуры для запуска: NOC‑room и два первых кластера. Туда мы устанавливали оборудование, которое зарекомендовало себя и на предыдущих площадках: серверы и дисковые полки в стойки 19". Чтобы поддерживать нужную температуру в кластерах, было необходимо охлаждение. С инженерной точки зрения, существующая на тот момент схема кондиционирования использовала доохлаждение — для получения холода требовалась дополнительная энергия. Поэтому был запущен Центр холодоснабжения с абсорбционными холодильными машинами:  Нагретый серверами воздух удалялся из каждой стойки по индивидуальным вентканалам. Стойка была скорее частью инженерной системы. Наши масштабы росли всё быстрее, и нам было нужно всё больше таких стоек с серверами. Деплой каждой требовал времени: Каждый сервер вынуть из коробки.Снять упаковочные материалы. В стойку установить 360+ сухарей/собачек.

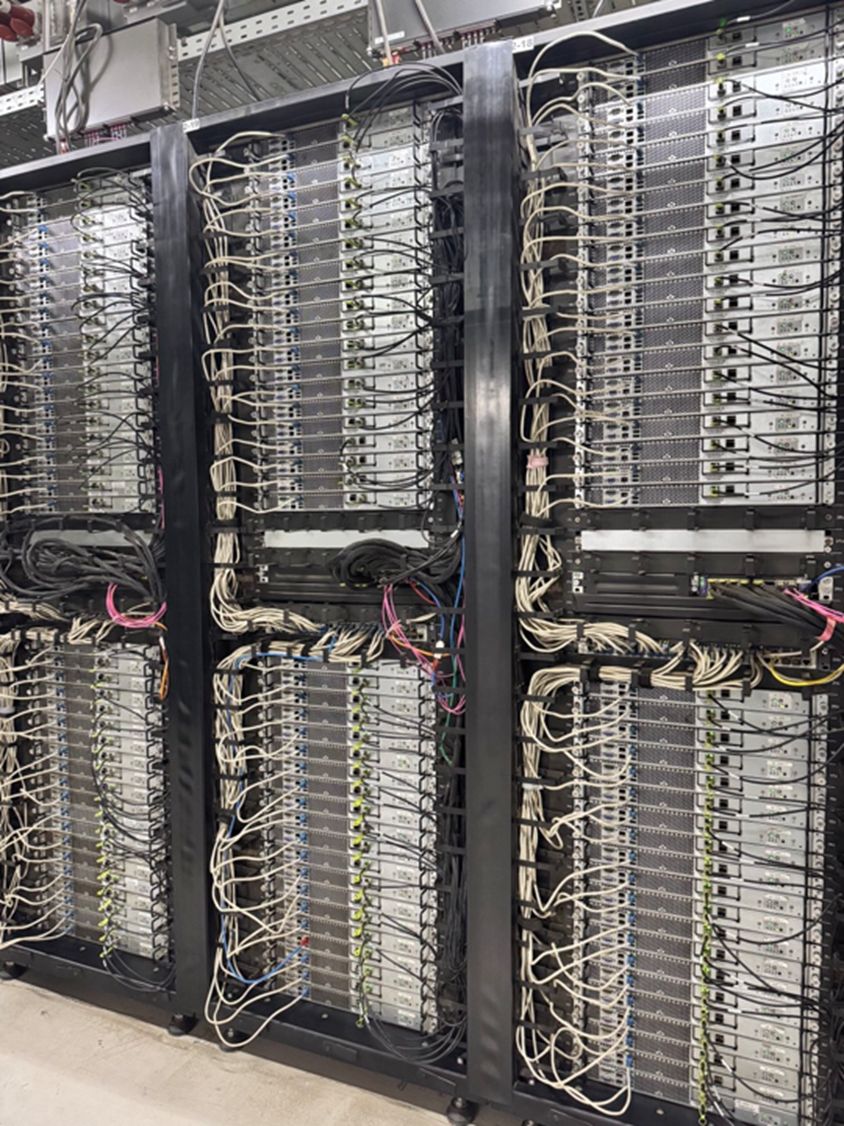

Нагретый серверами воздух удалялся из каждой стойки по индивидуальным вентканалам. Стойка была скорее частью инженерной системы. Наши масштабы росли всё быстрее, и нам было нужно всё больше таких стоек с серверами. Деплой каждой требовал времени: Каждый сервер вынуть из коробки.Снять упаковочные материалы. В стойку установить 360+ сухарей/собачек. Накрутить 94 салазки.Установить 47 серверов.Распаковать и скоммутировать сеть управления, сеть передачи данных, подключить кабели питания. На каждую стойку уходило примерно 1,5–2 человекодня… Мы стали думать, как сократить это время. 2013: первые стоечные решения В следующем году запустился новый модуль с разделением на горячий и холодный коридор, где можно было ставить не только стандартные стойки 19", но и стоечные решения по стандарту The Open Rack.

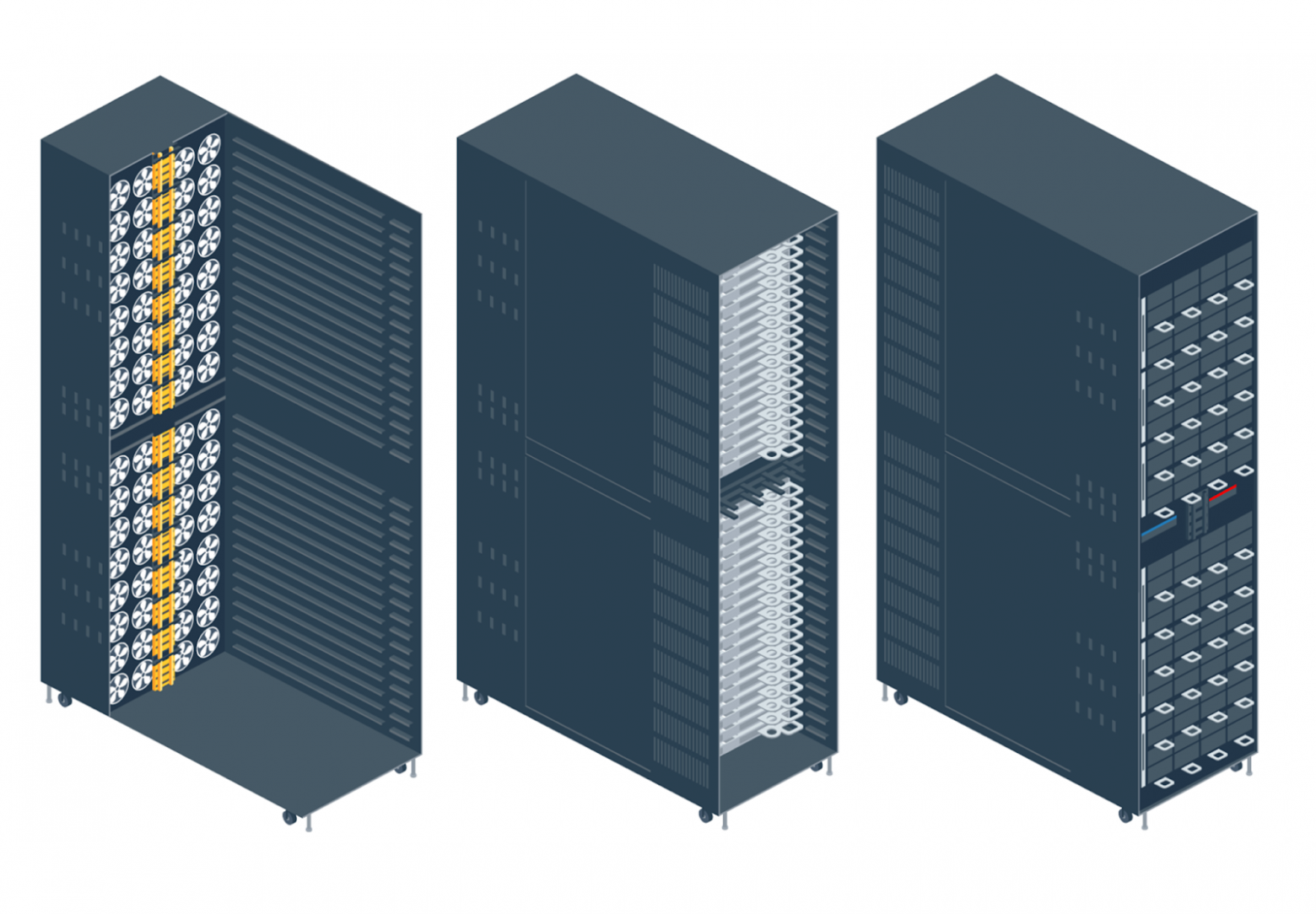

Накрутить 94 салазки.Установить 47 серверов.Распаковать и скоммутировать сеть управления, сеть передачи данных, подключить кабели питания. На каждую стойку уходило примерно 1,5–2 человекодня… Мы стали думать, как сократить это время. 2013: первые стоечные решения В следующем году запустился новый модуль с разделением на горячий и холодный коридор, где можно было ставить не только стандартные стойки 19", но и стоечные решения по стандарту The Open Rack.  Это стойка, в которой серверы не имеют собственного активного охлаждения и блоков питания, а подключены к централизованной системе: всё подключение к питанию предусмотрено в задней части с помощью специальной шины питания — тогда она была на 12 В. Охлаждение тоже интегрированное.

Это стойка, в которой серверы не имеют собственного активного охлаждения и блоков питания, а подключены к централизованной системе: всё подключение к питанию предусмотрено в задней части с помощью специальной шины питания — тогда она была на 12 В. Охлаждение тоже интегрированное.  Самое главное — такие решения можно доставить в дата‑центр уже в собранном виде. Некоторые модели приезжали даже с коммутацией, и это был настоящий прорыв. Первые подобные стойки мы заказали у сторонних производителей, а затем наладили своё производство с опорой на стандарты Open Compute Project Foundation (OCP) и стали устанавливать стоечные решения, разработанные Яндексом. 2017: переход на фрикулинг Следующие годы были посвящены повышению эффективности работы всей системы. Инженеры дата‑центра тестировали фрикулинг — систему, где всё оборудование охлаждается исключительно уличным воздухом. В плане инженерной инфраструктуры это также было прорывное решение, которое обещало серьёзную экономию ресурсов, так что мы использовали его при проектировании и строительстве новых модулей в нашем дата‑центре.

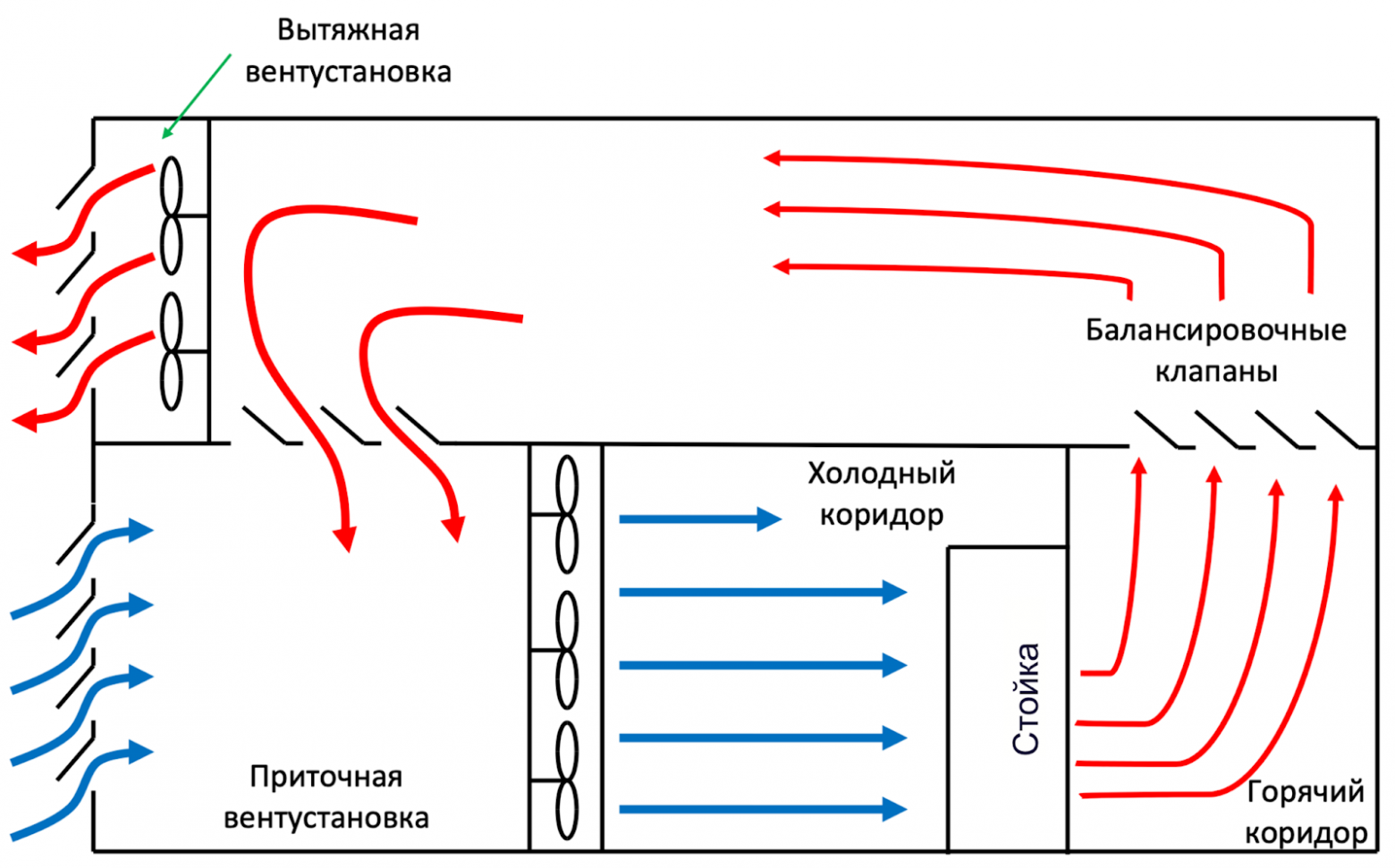

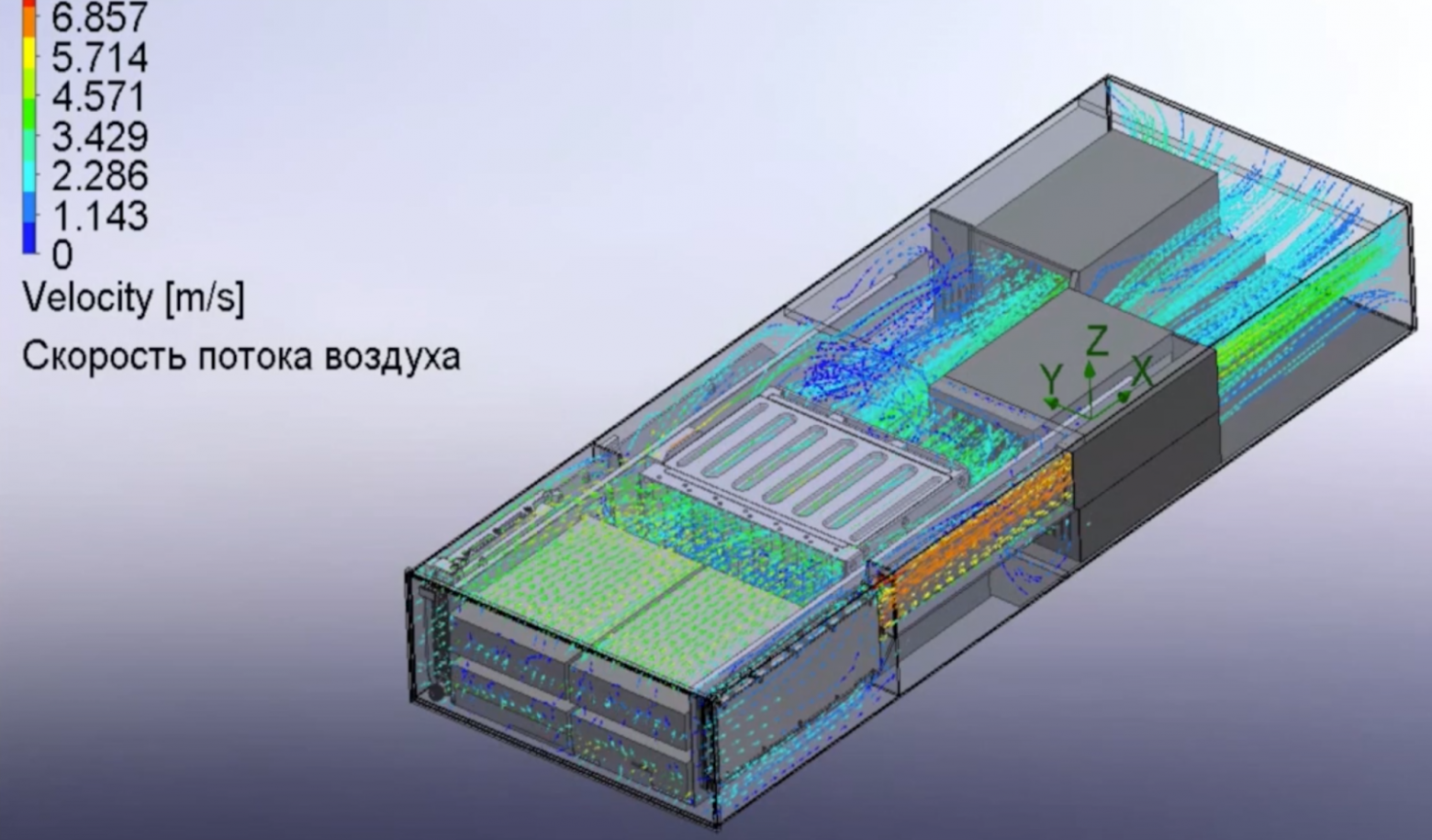

Самое главное — такие решения можно доставить в дата‑центр уже в собранном виде. Некоторые модели приезжали даже с коммутацией, и это был настоящий прорыв. Первые подобные стойки мы заказали у сторонних производителей, а затем наладили своё производство с опорой на стандарты Open Compute Project Foundation (OCP) и стали устанавливать стоечные решения, разработанные Яндексом. 2017: переход на фрикулинг Следующие годы были посвящены повышению эффективности работы всей системы. Инженеры дата‑центра тестировали фрикулинг — систему, где всё оборудование охлаждается исключительно уличным воздухом. В плане инженерной инфраструктуры это также было прорывное решение, которое обещало серьёзную экономию ресурсов, так что мы использовали его при проектировании и строительстве новых модулей в нашем дата‑центре.  Суть фрикулинга в том, что в холодный коридор поступает воздух БЕЗ доохлаждения: летом — это уличный воздух, а зимой используется уличный воздух с подмесом нагретого воздуха из горячего коридора, чтобы довести минусовую температуру до комфортных 20 градусов. Такое решение позволило отказаться от использования громоздких, сложных в эксплуатации холодильных машин. На Хабре уже было несколько статей о разных системах охлаждения дата‑центров, поэтому лишь вкратце напомню, как именно в случае фрикулинга поддерживается нужная температура:

Суть фрикулинга в том, что в холодный коридор поступает воздух БЕЗ доохлаждения: летом — это уличный воздух, а зимой используется уличный воздух с подмесом нагретого воздуха из горячего коридора, чтобы довести минусовую температуру до комфортных 20 градусов. Такое решение позволило отказаться от использования громоздких, сложных в эксплуатации холодильных машин. На Хабре уже было несколько статей о разных системах охлаждения дата‑центров, поэтому лишь вкратце напомню, как именно в случае фрикулинга поддерживается нужная температура:  В приточной установке установлены фильтры грубой и тонкой очистки.В холодном коридоре поддерживается положительное давление, в горячем — отрицательное.Сам расход холодного воздуха определяется потребностью стоек. С точки зрения IT‑поддержки важно, что отказ от доохлаждения помогает улучшить PUE (Power Usage Effectiveness) — коэффициент, отражающий эффективность использования энергии в дата‑центре. При использовании доохлаждения PUE находился в районе 1,5, а без него — держится на отметке 1,1, а иногда и меньше. Это значит, что только 10% от всего потребления дата‑центра уходит не на IT‑нужды. К тому моменту мы уже разработали стоечные решения, которые умели работать при температурах до +40 градусов. Поскольку все наши дата‑центры находятся в средней полосе России, такая температура — скорее аномалия. Но периодически кратковременные периоды жары всё же случаются, и было важно убедиться, что система справится. Поэтому даже стойки OCP первого и второго поколения подвергались самым разным испытаниям в нашей термолаборатории, и показали хорошую работоспособность при высоких температурах. А следующие поколения стоек нашей разработки изначально проектировались для нормальной работы в таких условиях. Это делало систему ещё эффективнее, так как доохлаждать было не нужно. 2017: новый дата-центр с новыми подходами

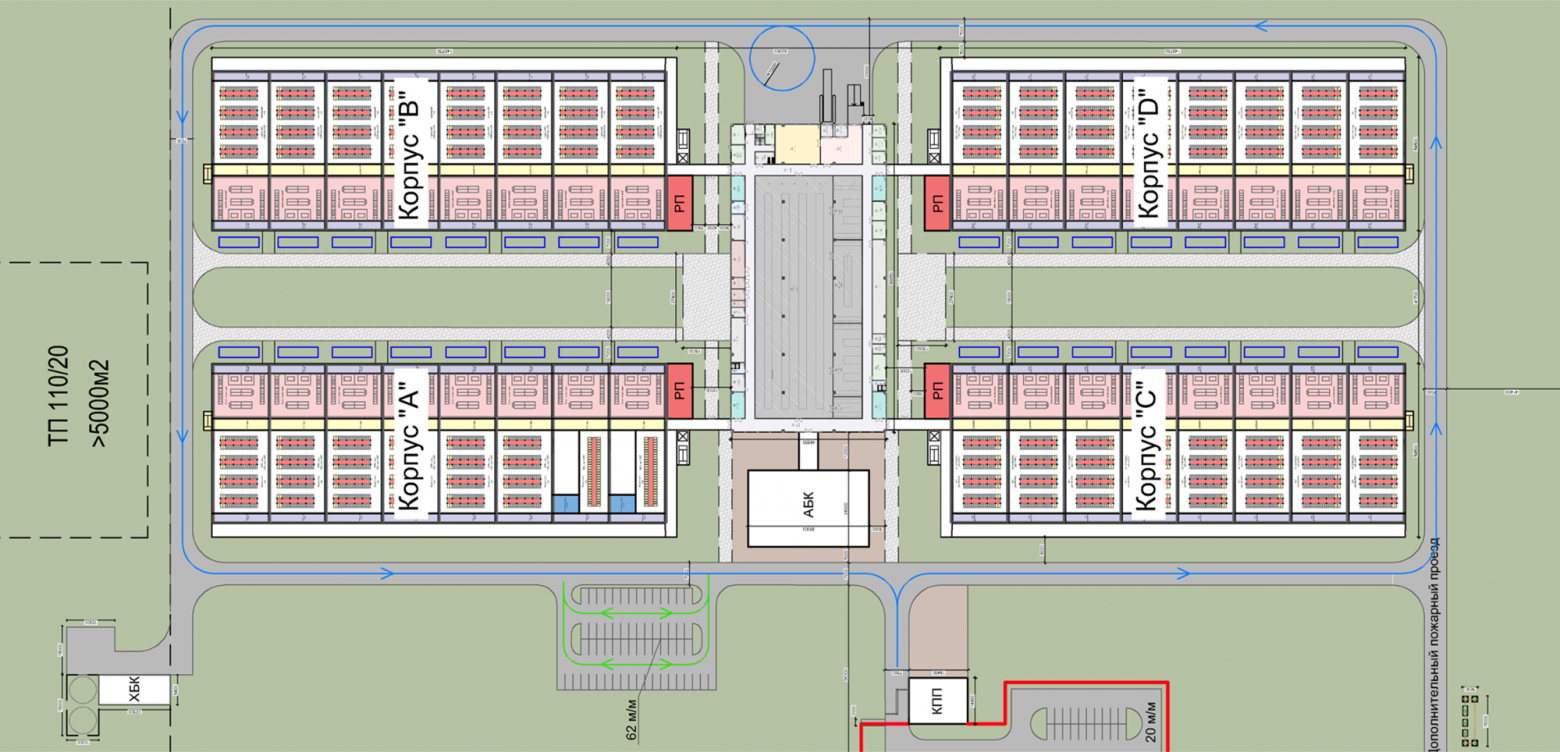

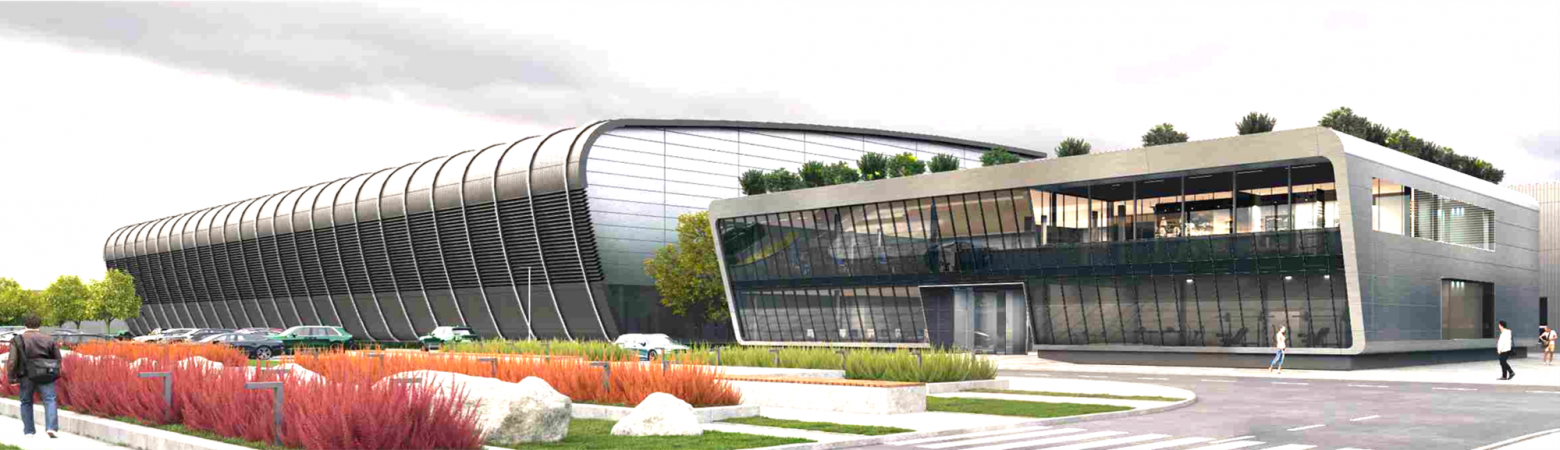

В приточной установке установлены фильтры грубой и тонкой очистки.В холодном коридоре поддерживается положительное давление, в горячем — отрицательное.Сам расход холодного воздуха определяется потребностью стоек. С точки зрения IT‑поддержки важно, что отказ от доохлаждения помогает улучшить PUE (Power Usage Effectiveness) — коэффициент, отражающий эффективность использования энергии в дата‑центре. При использовании доохлаждения PUE находился в районе 1,5, а без него — держится на отметке 1,1, а иногда и меньше. Это значит, что только 10% от всего потребления дата‑центра уходит не на IT‑нужды. К тому моменту мы уже разработали стоечные решения, которые умели работать при температурах до +40 градусов. Поскольку все наши дата‑центры находятся в средней полосе России, такая температура — скорее аномалия. Но периодически кратковременные периоды жары всё же случаются, и было важно убедиться, что система справится. Поэтому даже стойки OCP первого и второго поколения подвергались самым разным испытаниям в нашей термолаборатории, и показали хорошую работоспособность при высоких температурах. А следующие поколения стоек нашей разработки изначально проектировались для нормальной работы в таких условиях. Это делало систему ещё эффективнее, так как доохлаждать было не нужно. 2017: новый дата-центр с новыми подходами  В том же году запустился новый дата‑центр во Владимире, который изначально был спроектирован под фрикулинг и построен с нулевого цикла — такие строительные работы включали целый комплекс подготовительных мер, например, создание фундамента, прокладку необходимых коммуникаций и так далее. Если в старом дата‑центре для строительства кластера на фрикулинге в бывшем заводском помещении понадобилось убирать старые полы и заливать новые, чтобы разместить инженерное оборудование по высоте, то здесь эти моменты учли ещё на старте строительства. Заодно избавились от проблемы строительной пыли, которая неизбежно появлялась при модернизации старого здания. Новый дата‑центр спроектировали как четыре отдельных помещения с сетевой связностью между ними. Строили его по мере роста масштабов: как только начинало заполняться первое здание — вводилось в эксплуатацию следующее. Так мы могли избежать простаивающих помещений. Строительной пыли тоже стало меньше. Но со временем стало понятно, что нам не очень удобно перемещаться по улице между отдельными зданиями, а тем более транспортировать стойки из здания в здание. 2022: проектирование «жука» Учитывая весь накопленный опыт эксплуатации, новую площадку мы задумали как возможность объединить всё лучшее из существующих дата‑центров, а также избежать тех неудобств, которые возникли со временем. Так появился новый проект дата‑центров: с фрикулингом;с безразрывной крышей, как в первом дата-центре;с помещениями машинных залов, которые отделены друг от друга дверями. Сверху на плане выглядело так: в центре складские помещения и офис, а в стороны расходятся четыре помещения для строительства кластеров. Было похоже на насекомое, поэтому мы прозвали этот проект «жук».

В том же году запустился новый дата‑центр во Владимире, который изначально был спроектирован под фрикулинг и построен с нулевого цикла — такие строительные работы включали целый комплекс подготовительных мер, например, создание фундамента, прокладку необходимых коммуникаций и так далее. Если в старом дата‑центре для строительства кластера на фрикулинге в бывшем заводском помещении понадобилось убирать старые полы и заливать новые, чтобы разместить инженерное оборудование по высоте, то здесь эти моменты учли ещё на старте строительства. Заодно избавились от проблемы строительной пыли, которая неизбежно появлялась при модернизации старого здания. Новый дата‑центр спроектировали как четыре отдельных помещения с сетевой связностью между ними. Строили его по мере роста масштабов: как только начинало заполняться первое здание — вводилось в эксплуатацию следующее. Так мы могли избежать простаивающих помещений. Строительной пыли тоже стало меньше. Но со временем стало понятно, что нам не очень удобно перемещаться по улице между отдельными зданиями, а тем более транспортировать стойки из здания в здание. 2022: проектирование «жука» Учитывая весь накопленный опыт эксплуатации, новую площадку мы задумали как возможность объединить всё лучшее из существующих дата‑центров, а также избежать тех неудобств, которые возникли со временем. Так появился новый проект дата‑центров: с фрикулингом;с безразрывной крышей, как в первом дата-центре;с помещениями машинных залов, которые отделены друг от друга дверями. Сверху на плане выглядело так: в центре складские помещения и офис, а в стороны расходятся четыре помещения для строительства кластеров. Было похоже на насекомое, поэтому мы прозвали этот проект «жук».  В таком едином помещении нет пыли, корпуса по‑прежнему можно вводить в эксплуатацию по мере заполнения, но поскольку они расположены близко, то перемещение в любую погоду комфортное, а переезд IT‑оборудования между модулями проходит беспрепятственно. В недавно прошедший день работников дата‑центров мы даже заказали торт, вдохновлённый этим проектом:

В таком едином помещении нет пыли, корпуса по‑прежнему можно вводить в эксплуатацию по мере заполнения, но поскольку они расположены близко, то перемещение в любую погоду комфортное, а переезд IT‑оборудования между модулями проходит беспрепятственно. В недавно прошедший день работников дата‑центров мы даже заказали торт, вдохновлённый этим проектом:  2025: жизнь первых дата-центров Ввод новых площадок в эксплуатацию не означает, что мы забываем про прежние дата‑центры. К настоящему моменту в серверных стойках мы перешли уже к четвёртому поколению серверов, и для них требуется совсем другая инфраструктура, чем было 10–12 лет назад:

2025: жизнь первых дата-центров Ввод новых площадок в эксплуатацию не означает, что мы забываем про прежние дата‑центры. К настоящему моменту в серверных стойках мы перешли уже к четвёртому поколению серверов, и для них требуется совсем другая инфраструктура, чем было 10–12 лет назад:  Сервер 4.0 предусматривает: более эффективное охлаждение на 10–15%;питание 48 В на сервер (ноду);вместо четырёх NVMe‑дисков теперь шесть, и есть возможность установки двух дисков M2;возможность установки GPU. Само стоечное решение выглядит уже так:

Сервер 4.0 предусматривает: более эффективное охлаждение на 10–15%;питание 48 В на сервер (ноду);вместо четырёх NVMe‑дисков теперь шесть, и есть возможность установки двух дисков M2;возможность установки GPU. Само стоечное решение выглядит уже так:  С 2023 года мы ведём работы по модернизации старой части нашей первой площадки. Это позволяет полностью отказаться от доохлаждения и демонтировать оставшееся холодильное оборудование, которое не позволяло установить в старые модули современные устройства. 2026: что будет дальше?

С 2023 года мы ведём работы по модернизации старой части нашей первой площадки. Это позволяет полностью отказаться от доохлаждения и демонтировать оставшееся холодильное оборудование, которое не позволяло установить в старые модули современные устройства. 2026: что будет дальше?  Дата‑центры будущего уже рядом с нами, и вот как они выглядят для нас сейчас: современное помещение, которое сочетает удобство и надёжность;возможность запускать площадку даже с одним модулем и достраивать остальные по мере необходимости;экономичное расходование энергии с PUE не более 1,1;стойки приезжают в дата‑центр в сборе и отправляются в тестирование через 30–40 минут с момента разгрузки фуры. Уже можно представить, как это будет развиваться дальше: Виден рост потребностей в мощностях для ML‑задач, которые потребляют много электроэнергии. Поэтому площадки будут заполняться очень быстро.Если первые кластеры потребляли киловатты, а существующие якорные дата‑центры — 40–60 МВт, то площадки ближайшего будущего проектируется уже с мощностью 120 и более МВт.Масштабироваться мы и дальше будем площадками, и это будет несколько обособленных сооружений в непосредственной близости, например, как наш «жук».Постоянно увеличивающийся TDP чипов обязывает постепенно переходить к системам жидкостного охлаждения, как в инженерных системах дата‑центров, так и внутри серверов.

Дата‑центры будущего уже рядом с нами, и вот как они выглядят для нас сейчас: современное помещение, которое сочетает удобство и надёжность;возможность запускать площадку даже с одним модулем и достраивать остальные по мере необходимости;экономичное расходование энергии с PUE не более 1,1;стойки приезжают в дата‑центр в сборе и отправляются в тестирование через 30–40 минут с момента разгрузки фуры. Уже можно представить, как это будет развиваться дальше: Виден рост потребностей в мощностях для ML‑задач, которые потребляют много электроэнергии. Поэтому площадки будут заполняться очень быстро.Если первые кластеры потребляли киловатты, а существующие якорные дата‑центры — 40–60 МВт, то площадки ближайшего будущего проектируется уже с мощностью 120 и более МВт.Масштабироваться мы и дальше будем площадками, и это будет несколько обособленных сооружений в непосредственной близости, например, как наш «жук».Постоянно увеличивающийся TDP чипов обязывает постепенно переходить к системам жидкостного охлаждения, как в инженерных системах дата‑центров, так и внутри серверов.  Иногда я спрашиваю коллег, работающих в дата‑центре, как они видят будущее нашей площадки. Многие отвечают, что чинить серверы будут роботы (а сотрудники IT‑поддержки, по‑видимому, будут чинить роботов). Но с точки зрения эксплуатации это не так уж далеко от истины. В идеале хочется, чтобы это выглядело так: прихожу в дата‑центр, иду в офис;умная колонка меня приветствует и рассказывает про запланированные на день задачи в формате саммари, докладывает об уровне SLA и каких‑либо изменениях;по цеху ходят сотрудники службы контроля качества в очках дополненной реальности, на которых видны необходимые операции с оборудованием; роботы‑доставщики вокруг развозят компоненты на склад и со склада до места проведения работ;в офисе сидят IT‑специалисты, которые выполняют сложную диагностику, давая задачи AI‑ассистентам. Пока часть из этого ещё не сбылось, но многие из технологий мы уже тестируем. Так что поживём‑увидим! yandex.cloud/ru...

Иногда я спрашиваю коллег, работающих в дата‑центре, как они видят будущее нашей площадки. Многие отвечают, что чинить серверы будут роботы (а сотрудники IT‑поддержки, по‑видимому, будут чинить роботов). Но с точки зрения эксплуатации это не так уж далеко от истины. В идеале хочется, чтобы это выглядело так: прихожу в дата‑центр, иду в офис;умная колонка меня приветствует и рассказывает про запланированные на день задачи в формате саммари, докладывает об уровне SLA и каких‑либо изменениях;по цеху ходят сотрудники службы контроля качества в очках дополненной реальности, на которых видны необходимые операции с оборудованием; роботы‑доставщики вокруг развозят компоненты на склад и со склада до места проведения работ;в офисе сидят IT‑специалисты, которые выполняют сложную диагностику, давая задачи AI‑ассистентам. Пока часть из этого ещё не сбылось, но многие из технологий мы уже тестируем. Так что поживём‑увидим! yandex.cloud/ru...

С 6 октября 2025 г. изменился юридический адрес, КПП и ОКАТО Новый юридический адрес: 127254, г. Москва, вн.тер.г. Муниципальный округ Бутырский, проезд Огородный, д.16/1, стр. 5, помещение 605 Новый КПП: 771501001 Новый ОКАТО: 45280561000 Все остальные реквизиты прежние...

С 6 октября 2025 г. изменился юридический адрес, КПП и ОКАТО Новый юридический адрес: 127254, г. Москва, вн.тер.г. Муниципальный округ Бутырский, проезд Огородный, д.16/1, стр. 5, помещение 605 Новый КПП: 771501001 Новый ОКАТО: 45280561000 Все остальные реквизиты прежние...

Приобретайте SSL-сертификат от GlobalSign по специальной цене! ❗️ Преимущества сертификата GlobalSign AlphaSSL: — Полностью защищенное соединение HTTPS, повышение доверия пользователей. — Поддержка всех современных браузеров и устройств. — Простота установки и настройка под ключ. ❗️ Акция действует ограниченное время для владельцев любых активных виртуальных серверов (кроме промо и заказав посуточно). Сертификаты регистрируются сроком на один год. Акция не распространяется на продление сертификатов. В рамках акции стоимость регистрации сертификата составляет 950 ₽. Каждому клиенту по сниженной цене может быть зарегистрировано не более 1 (одного) сертификата. Все последующие регистрации будут производиться по стандартной цене. Сайт: elenahost.ru Личный кабинет: billing.elenahost.ru...

Приобретайте SSL-сертификат от GlobalSign по специальной цене! ❗️ Преимущества сертификата GlobalSign AlphaSSL: — Полностью защищенное соединение HTTPS, повышение доверия пользователей. — Поддержка всех современных браузеров и устройств. — Простота установки и настройка под ключ. ❗️ Акция действует ограниченное время для владельцев любых активных виртуальных серверов (кроме промо и заказав посуточно). Сертификаты регистрируются сроком на один год. Акция не распространяется на продление сертификатов. В рамках акции стоимость регистрации сертификата составляет 950 ₽. Каждому клиенту по сниженной цене может быть зарегистрировано не более 1 (одного) сертификата. Все последующие регистрации будут производиться по стандартной цене. Сайт: elenahost.ru Личный кабинет: billing.elenahost.ru...

Сегодня финальный день для заказа выделенных серверов со скидкой 30%. До 23:59 по мск вы можете: зафиксировать цену на 1, 3, 6 или 12 месяцев вперед,получить дополнительно специальную цену за период,увеличить производительность сохранив бюджета.Примеры конфигураций:

Сегодня финальный день для заказа выделенных серверов со скидкой 30%. До 23:59 по мск вы можете: зафиксировать цену на 1, 3, 6 или 12 месяцев вперед,получить дополнительно специальную цену за период,увеличить производительность сохранив бюджета.Примеры конфигураций:  1dedic.ru...

1dedic.ru...

Здравствуйте! У нас важная новость — компания IT4ALL меняет название. Теперь мы — Zepher. Мы остаёмся той же командой специалистов, с теми же ценностями и качеством сервиса, но под новым именем и с обновлённым визуальным образом. Что изменится: Новое имя: Zepher В ближайшее время заработает наш новый сайт — zepher.ru Почтовые сообщения будут приходить с домена @zepher.ru До конца года будет продолжать работать прежний домен it4all.ru В переходный период вы можете видеть два логотипа — IT4ALL и Zepher. Это нормально: они будут использоваться совместно, пока процесс обновления завершится. Никаких действий с вашей стороны не требуется — все наши контакты и договорные обязательства остаются в силе. Почему мы проводим ребрендинг: it4all.ru/rebranding/ Мы приняли решение о ребрендинге и смене названия IT4ALL на Zepher. Это решение связано с необходимостью избежать юридических разногласий, возникших из-за совпадения нашего названия с зарегистрированным товарным знаком другой компании. Мы работаем под брендом IT4ALL с 2018 года и продолжаем придерживаться тех же принципов и стандартов качества. Однако, чтобы не создавать правовых рисков и обеспечить стабильность проекта, мы решили перейти на новое имя — Zepher, под которым будем развиваться дальше. Все наши сервисы и команда остаются прежними. Меняется только название — и появляются новые возможности. Спасибо, что вы с нами! Команда Zepher (ранее IT4ALL)...

Здравствуйте! У нас важная новость — компания IT4ALL меняет название. Теперь мы — Zepher. Мы остаёмся той же командой специалистов, с теми же ценностями и качеством сервиса, но под новым именем и с обновлённым визуальным образом. Что изменится: Новое имя: Zepher В ближайшее время заработает наш новый сайт — zepher.ru Почтовые сообщения будут приходить с домена @zepher.ru До конца года будет продолжать работать прежний домен it4all.ru В переходный период вы можете видеть два логотипа — IT4ALL и Zepher. Это нормально: они будут использоваться совместно, пока процесс обновления завершится. Никаких действий с вашей стороны не требуется — все наши контакты и договорные обязательства остаются в силе. Почему мы проводим ребрендинг: it4all.ru/rebranding/ Мы приняли решение о ребрендинге и смене названия IT4ALL на Zepher. Это решение связано с необходимостью избежать юридических разногласий, возникших из-за совпадения нашего названия с зарегистрированным товарным знаком другой компании. Мы работаем под брендом IT4ALL с 2018 года и продолжаем придерживаться тех же принципов и стандартов качества. Однако, чтобы не создавать правовых рисков и обеспечить стабильность проекта, мы решили перейти на новое имя — Zepher, под которым будем развиваться дальше. Все наши сервисы и команда остаются прежними. Меняется только название — и появляются новые возможности. Спасибо, что вы с нами! Команда Zepher (ранее IT4ALL)...

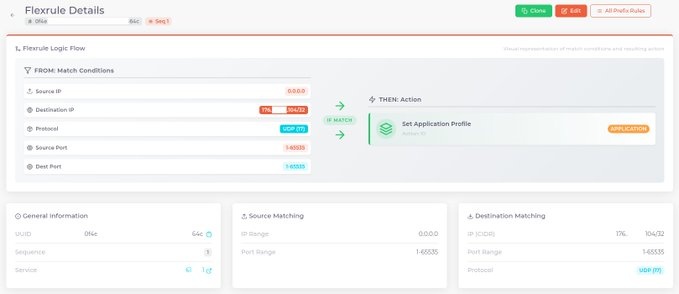

Клиенты с сеансами BGP теперь могут просматривать активные объявления BGP, включая состояние их проверки (RIR/RPKI)...

Клиенты с сеансами BGP теперь могут просматривать активные объявления BGP, включая состояние их проверки (RIR/RPKI)...

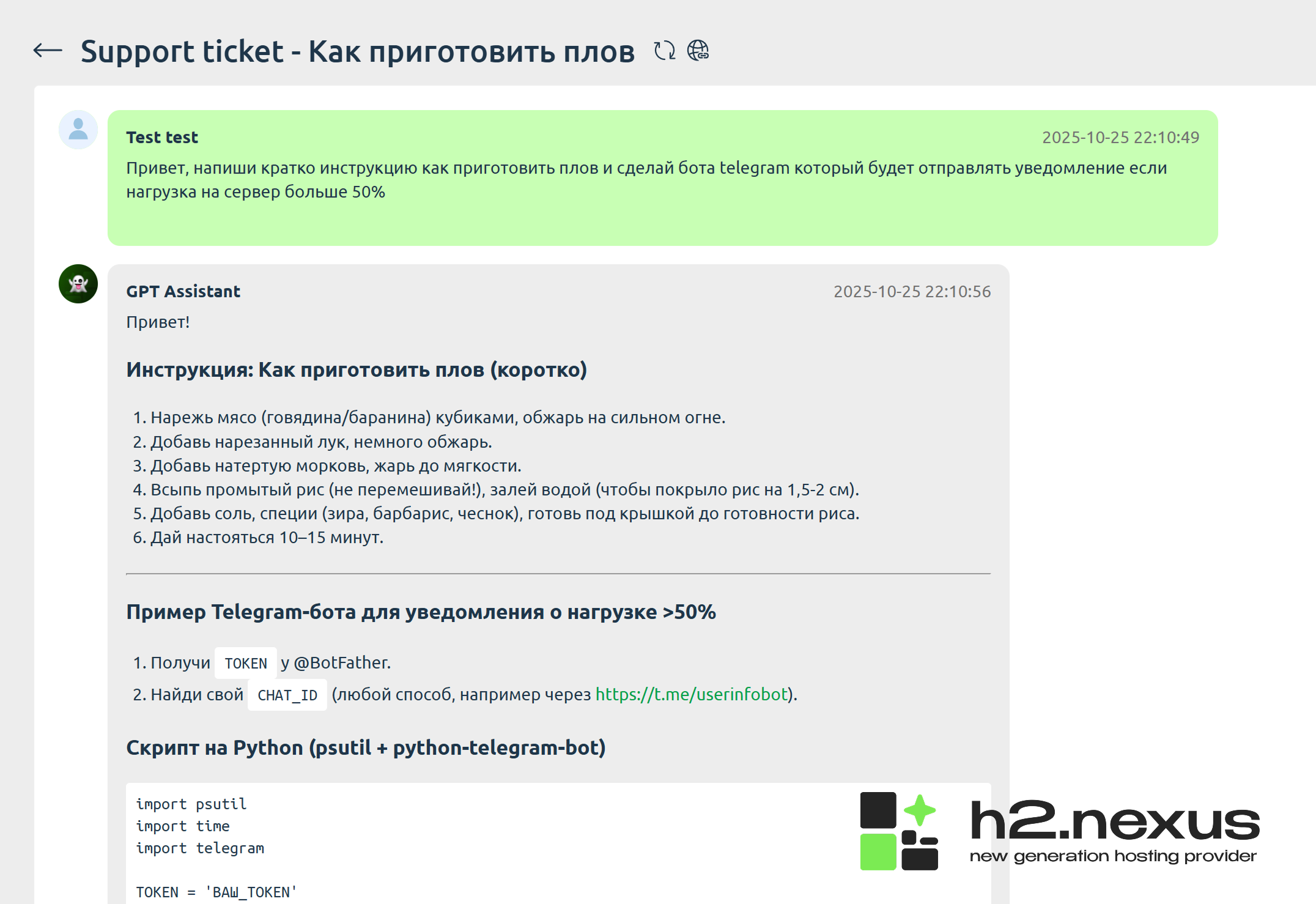

Привет! Мы добавили новую функцию для всех наших клиентов: теперь вы можете выбрать «GPT Assistant» при создании запроса в личном кабинете и получить ответ от последней версии ChatGPT. Доступно круглосуточно и совершенно бесплатно. Это значительно снизит нагрузку на нашу службу поддержки, повысит скорость ответа на запросы которые не способен решить GPT, а наши клиенты смогут воспользоваться совершенно новой функцией, которая позволяет решать широкий спектр задач в режиме реального времени на любом языке. Уже доступно для всех, попробуйте сами — my.h2.nexus Есть вопросы? Обращайтесь: @h2nexus_support H2.NEXUS...

Привет! Мы добавили новую функцию для всех наших клиентов: теперь вы можете выбрать «GPT Assistant» при создании запроса в личном кабинете и получить ответ от последней версии ChatGPT. Доступно круглосуточно и совершенно бесплатно. Это значительно снизит нагрузку на нашу службу поддержки, повысит скорость ответа на запросы которые не способен решить GPT, а наши клиенты смогут воспользоваться совершенно новой функцией, которая позволяет решать широкий спектр задач в режиме реального времени на любом языке. Уже доступно для всех, попробуйте сами — my.h2.nexus Есть вопросы? Обращайтесь: @h2nexus_support H2.NEXUS...

Спасибо, что читаете наши письма Мы тут посмотрели стату и заметили, что вы читаете все — дайджесты, письма с релизами и даже технические рассылки. Такую вовлеченность точно нельзя оставлять без внимания. Для этого подготовили бонус — промокод LONG10, который добавит +10% к вашему следующему платежу. Просто введите его перед оплатой на странице «Бонусы и промокоды». timeweb.cloud/my/finances/bonuses Промокод действует до 31 октября 2025 — успевайте воспользоваться. А мы убегаем готовить для вас новые интересные материалы...

Спасибо, что читаете наши письма Мы тут посмотрели стату и заметили, что вы читаете все — дайджесты, письма с релизами и даже технические рассылки. Такую вовлеченность точно нельзя оставлять без внимания. Для этого подготовили бонус — промокод LONG10, который добавит +10% к вашему следующему платежу. Просто введите его перед оплатой на странице «Бонусы и промокоды». timeweb.cloud/my/finances/bonuses Промокод действует до 31 октября 2025 — успевайте воспользоваться. А мы убегаем готовить для вас новые интересные материалы...

Мы улучшили дополнительный диск, доступный для ваших VDS-серверов в Sprintbox. На замену «Ice Storage» приходит «Дополнительный диск». Современные NVMe-диски обеспечивают в 5–7 раз более высокую скорость доступа к данным и значительно большую надёжность. Что изменится Все активные пользователи услуги «Ice Storage» уже переведены на новый NVMe-диск.Новая стоимость услуги «Дополнительный диск» составит 490 ₽ в месяц.Изменения вступят в силу через 14 дней — с 07.11.25.(Если услуга Ice Storage подключена у вас сейчас, цена изменится автоматически после указанной даты.) Почему это улучшение Скорость чтения и записи данных в несколько раз выше; дополнительный диск работает так же быстро как основной.Резервное копирование данных «Дополнительного диска» осуществляется вместе с боксом.Диск подключается так же, как раньше — без необходимости менять настройки. Для тех, кто ещё не подключал диск Теперь это отличная возможность попробовать обновлённый сервис. Добавьте NVMe-диск к своему боксу всего за 490 ₽/мес (услуга предоставляется по тарифу 300 ₽/мес до 07.11.25) — храните бэкапы, архивы и проекты быстро и безопасно...

Мы улучшили дополнительный диск, доступный для ваших VDS-серверов в Sprintbox. На замену «Ice Storage» приходит «Дополнительный диск». Современные NVMe-диски обеспечивают в 5–7 раз более высокую скорость доступа к данным и значительно большую надёжность. Что изменится Все активные пользователи услуги «Ice Storage» уже переведены на новый NVMe-диск.Новая стоимость услуги «Дополнительный диск» составит 490 ₽ в месяц.Изменения вступят в силу через 14 дней — с 07.11.25.(Если услуга Ice Storage подключена у вас сейчас, цена изменится автоматически после указанной даты.) Почему это улучшение Скорость чтения и записи данных в несколько раз выше; дополнительный диск работает так же быстро как основной.Резервное копирование данных «Дополнительного диска» осуществляется вместе с боксом.Диск подключается так же, как раньше — без необходимости менять настройки. Для тех, кто ещё не подключал диск Теперь это отличная возможность попробовать обновлённый сервис. Добавьте NVMe-диск к своему боксу всего за 490 ₽/мес (услуга предоставляется по тарифу 300 ₽/мес до 07.11.25) — храните бэкапы, архивы и проекты быстро и безопасно...

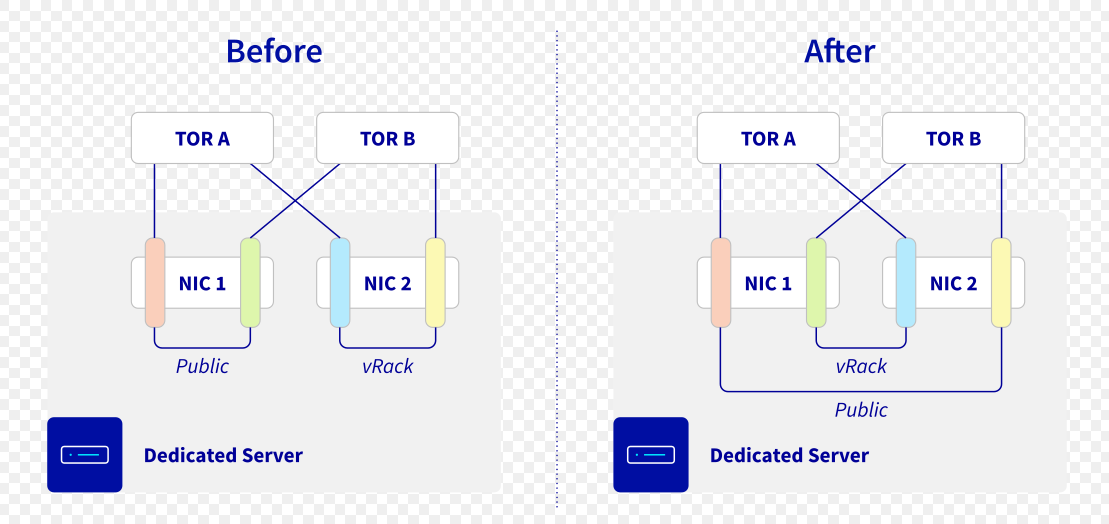

В рамках постоянного совершенствования нашей инфраструктуры Bare Metal компания OVHcloud представляет новую архитектуру агрегации сетей, призванную повысить устойчивость публичных и частных интерфейсов ваших серверов. Что меняется? До сих пор агрегация каналов (LACP) для сетевых интерфейсов осуществлялась с использованием портов, принадлежащих одной сетевой карте (NIC). Хотя это и обеспечивало резервирование на случай отказа коммутатора ToR (Top-of-Rack), это не исключало риск отказа сетевой карты. Мы обновим эту функциональность с 25 ноября 2025 года. Вы обеспокоены, если Вы настроили агрегацию LACP ваших публичных или частных каналов (исключая OLA).Вы настроили OLA на своем сервере и хотите вернуться к общедоступной/частной конфигурации по умолчанию.После этого обновления Существующие агрегации не будут изменены автоматически.Переключение в режим OLA, а затем возврат в режим по умолчанию вызовет перенастройку и, следовательно, применение нового правила агрегации.Изменение конфигурации агрегаций логически перераспределит их по двум отдельным сетевым картам (без изменения физической кабельной разводки).После применения нового правила вернуться к старому режиму будет невозможно.Для серверов, поставленных после этого обновления, будет применяться только новое правило агрегации.  Панель управления OVHcloud отображает схему агрегации, которую можно настроить на вашем сервере. Эта же информация доступна через API OVHcloud /dedicated/server/{serviceName}/virtualNetworkInterface) /dedicated/server/{serviceName}/virtualNetworkInterface/{uuid} Если вы не используете агрегацию каналов LACP на своем сервере, никаких действий не требуется, и никакие изменения для ваших служб не будут видны Важное примечание, если вы настроили LACP на уровне ОС Если вы планируете перейти на это новое правило агрегации, вам потребуется обновить MAC-адреса, назначенные каждой связи в вашей операционной системе. Преимущества этого изменения При правильной настройке ОС новое правило обеспечивает: Более высокая доступность: повышенная отказоустойчивость к сбоям оборудования (сетевых карт, коммутаторов и кабелей).Непрерывное подключение: ваши услуги остаются доступными даже при выходе из строя одной сетевой карты.Плавная эволюция: это улучшение реализуется без влияния на вашу текущую конфигурацию. Хронология и документация Развертывание начнется 25 ноября 2025 года. Более подробную информацию см. в документации, касающейся этого изменения. OVHcloud по-прежнему стремится предоставлять еще более надежную, высокопроизводительную и безопасную инфраструктуру. help.ovhcloud.com/csm/en-dedicated-servers-improve-network-resilience Спасибо за ваше доверие OVHcloud...

Панель управления OVHcloud отображает схему агрегации, которую можно настроить на вашем сервере. Эта же информация доступна через API OVHcloud /dedicated/server/{serviceName}/virtualNetworkInterface) /dedicated/server/{serviceName}/virtualNetworkInterface/{uuid} Если вы не используете агрегацию каналов LACP на своем сервере, никаких действий не требуется, и никакие изменения для ваших служб не будут видны Важное примечание, если вы настроили LACP на уровне ОС Если вы планируете перейти на это новое правило агрегации, вам потребуется обновить MAC-адреса, назначенные каждой связи в вашей операционной системе. Преимущества этого изменения При правильной настройке ОС новое правило обеспечивает: Более высокая доступность: повышенная отказоустойчивость к сбоям оборудования (сетевых карт, коммутаторов и кабелей).Непрерывное подключение: ваши услуги остаются доступными даже при выходе из строя одной сетевой карты.Плавная эволюция: это улучшение реализуется без влияния на вашу текущую конфигурацию. Хронология и документация Развертывание начнется 25 ноября 2025 года. Более подробную информацию см. в документации, касающейся этого изменения. OVHcloud по-прежнему стремится предоставлять еще более надежную, высокопроизводительную и безопасную инфраструктуру. help.ovhcloud.com/csm/en-dedicated-servers-improve-network-resilience Спасибо за ваше доверие OVHcloud...

Приобретайте домены по выгодной цене вместе с вашим активным виртуальным сервером! Преимущества регистрации: ✅ Низкая стоимость – всего 39 рублей при заказе домена для клиентов с активным виртуальным сервером (кроме промо и заказав посуточно). ✅ Простота оформления – регистрация займет считанные минуты. ✅ Надежность и стабильность – защищенный доступ и высокая скорость загрузки сайта. ✅ Возможность выбора уникального имени для вашего проекта. Почему выбирают именно нас: Мы предлагаем надежные решения для ваших онлайн-проектов, будь то личный сайт, блог или крупный бизнес-ресурс. С нами ваш проект получит надежную площадку и узнаваемое название! ❗ Акция действует ограниченное время, успейте воспользоваться выгодным предложением! Регистрируйтесь прямо сейчас и сделайте первый шаг к успеху своего проекта! — Домены регистрируются сроком на один год. — Акция не распространяется на продление доменов. — В рамках акции стоимость регистрации домена .ru или.рф составляет 39 ₽. — Каждому клиенту по сниженной цене может быть зарегистрировано не более 1 (одного) домена. Все последующие регистрации будут производиться по стандартной цене. Сайт: elenahost.ru Личный кабинет: billing.elenahost.ru Оценили 0 человек Показать список поделившихся...

Приобретайте домены по выгодной цене вместе с вашим активным виртуальным сервером! Преимущества регистрации: ✅ Низкая стоимость – всего 39 рублей при заказе домена для клиентов с активным виртуальным сервером (кроме промо и заказав посуточно). ✅ Простота оформления – регистрация займет считанные минуты. ✅ Надежность и стабильность – защищенный доступ и высокая скорость загрузки сайта. ✅ Возможность выбора уникального имени для вашего проекта. Почему выбирают именно нас: Мы предлагаем надежные решения для ваших онлайн-проектов, будь то личный сайт, блог или крупный бизнес-ресурс. С нами ваш проект получит надежную площадку и узнаваемое название! ❗ Акция действует ограниченное время, успейте воспользоваться выгодным предложением! Регистрируйтесь прямо сейчас и сделайте первый шаг к успеху своего проекта! — Домены регистрируются сроком на один год. — Акция не распространяется на продление доменов. — В рамках акции стоимость регистрации домена .ru или.рф составляет 39 ₽. — Каждому клиенту по сниженной цене может быть зарегистрировано не более 1 (одного) домена. Все последующие регистрации будут производиться по стандартной цене. Сайт: elenahost.ru Личный кабинет: billing.elenahost.ru Оценили 0 человек Показать список поделившихся...

Отказоустойчивость — одно из ключевых требований для высоконагруженных инфраструктур. При организации таких систем основным условием является использование внешнего хранилища. Блочные устройства внешнего хранилища подключаются к узлам кластера через iSCSI, Fibre Channel или иные сетевые протоколы. Платформа виртуализации VMmanager позволяет автоматизировать подключение внешних iSCSI‑устройств ко всем узлам сразу. Раньше администратору приходилось вручную настраивать LVM‑тома на каждом узле кластера, подключать внешнее хранилище и активировать его на каждом сервере. После этого через интерфейс VMmanager добавлялось уже «готовое» устройство в качестве хранилища. Теперь все стало значительно проще: в интерфейсе VMmanager достаточно указать адрес внешней СХД, после чего платформа автоматически обнаружит доступные LUN‑устройства и предложит выбрать нужные для использования. Выбранное устройство будет сконфигурировано на всех узлах кластера, и администратор сможет предоставить это хранилище пользователям для размещения виртуальных машин. Такой подход позволяет минимизировать ручной труд, снизить риск ошибок при настройке, а также ускорить вывод инфраструктуры в рабочее состояние. Какие преимущества получает бизнес Скорость и простота. Весь процесс подключения занимает минуты: теперь нет необходимости настраивать каждый хост отдельно. Достаточно настроить конфигурацию подключения на одном хосте и применить заданные параметры на весь кластер или для выбранных узлов.Снижение риска ошибок. Ручная настройка — это всегда наличие ошибок из-за человеческого фактора. Автоматизация исключает этот риск.Централизованный мониторинг и контроль подключения хранилища. Платформа следит за тем, чтобы конфигурация хранилищ была одинаковой на всех узлах. Если произойдет нештатная ситуация и хранилище перестанет быть доступным, система сообщит об ошибке. Дорожная карта развития новой опции Сейчас функциональность находится в стадии активного развития. В ближайших планах: реализация управления подключениями по протоколу Fibre Channel;внедрение функции прямого подключения дисков (Direct LUN/Shared LUN). Что нужно пользователям для начала работы Если вы ставите систему с нуля из комплекта поставки VMmanager, все нужные компоненты уже есть «в коробке». Если вы обновляете платформу до новой версии, может потребоваться дополнительная установка пакетов. Мы рекомендуем обращаться к документации, чтобы уточнить детали вашей конфигурации. www.ispsystem.ru/docs/vmmanager-admin/hranilishcha/shd...

Отказоустойчивость — одно из ключевых требований для высоконагруженных инфраструктур. При организации таких систем основным условием является использование внешнего хранилища. Блочные устройства внешнего хранилища подключаются к узлам кластера через iSCSI, Fibre Channel или иные сетевые протоколы. Платформа виртуализации VMmanager позволяет автоматизировать подключение внешних iSCSI‑устройств ко всем узлам сразу. Раньше администратору приходилось вручную настраивать LVM‑тома на каждом узле кластера, подключать внешнее хранилище и активировать его на каждом сервере. После этого через интерфейс VMmanager добавлялось уже «готовое» устройство в качестве хранилища. Теперь все стало значительно проще: в интерфейсе VMmanager достаточно указать адрес внешней СХД, после чего платформа автоматически обнаружит доступные LUN‑устройства и предложит выбрать нужные для использования. Выбранное устройство будет сконфигурировано на всех узлах кластера, и администратор сможет предоставить это хранилище пользователям для размещения виртуальных машин. Такой подход позволяет минимизировать ручной труд, снизить риск ошибок при настройке, а также ускорить вывод инфраструктуры в рабочее состояние. Какие преимущества получает бизнес Скорость и простота. Весь процесс подключения занимает минуты: теперь нет необходимости настраивать каждый хост отдельно. Достаточно настроить конфигурацию подключения на одном хосте и применить заданные параметры на весь кластер или для выбранных узлов.Снижение риска ошибок. Ручная настройка — это всегда наличие ошибок из-за человеческого фактора. Автоматизация исключает этот риск.Централизованный мониторинг и контроль подключения хранилища. Платформа следит за тем, чтобы конфигурация хранилищ была одинаковой на всех узлах. Если произойдет нештатная ситуация и хранилище перестанет быть доступным, система сообщит об ошибке. Дорожная карта развития новой опции Сейчас функциональность находится в стадии активного развития. В ближайших планах: реализация управления подключениями по протоколу Fibre Channel;внедрение функции прямого подключения дисков (Direct LUN/Shared LUN). Что нужно пользователям для начала работы Если вы ставите систему с нуля из комплекта поставки VMmanager, все нужные компоненты уже есть «в коробке». Если вы обновляете платформу до новой версии, может потребоваться дополнительная установка пакетов. Мы рекомендуем обращаться к документации, чтобы уточнить детали вашей конфигурации. www.ispsystem.ru/docs/vmmanager-admin/hranilishcha/shd...