Решение представляет собой программный аналог классических маршрутизаторов и предназначен для упрощения управления сетями. Российский провайдер Рег.облако интегрировал в облачную платформу виртуальные роутеры. Сервис позволяет настраивать маршрутизацию трафика между виртуальными машинами, организовывать связность в приватных сетях и подключать ресурсы к интернету через единый IP-адрес по технологии NAT (механизм преобразования IP-адресов). www.reg.cloud/cloud/servers Новый продукт работает как программный аналог классического маршрутизатора. Архитектура решения построена с акцентом на безопасность, предлагая встроенные механизмы для изоляции трафика и защиты данных. Программное решение Рег.облака поможет организовать изолированные среды для разработки и тестирования с выходом в интернет и подключать их к корпоративному контуру через защищенные соединения. Виртуальные роутеры позволяют создавать сложные сетевые конфигурации без покупки и обслуживания дорогостоящего «железного» оборудования. Решение не только более экономично, но и предоставляет гибкость для масштабирования сети под меняющиеся бизнес-задачи, что особенно актуально для компаний с развитой облачной инфраструктурой комментирует Алексей Тюняев, директор по облачным продуктам Рег.облака. С новым сервисом Рег.облака компании получат важный инструмент для управления всей облачной сетевой инфраструктурой. А создание безопасных приватных сетей в облаке поможет сотрудникам эффективнее работать, в том числе, с корпоративными ресурсами. Рег.облако признан одним из лидеров рынка облачных услуг в 2025 году Облачный провайдер Рег.облако вошел в топ-3 крупнейших поставщиков услуг PaaS по версии TAdviser Analytics. Рег.облако, российский поставщик облачных и bare-metal решений, включен в авторитетный обзор об облачных сервисах для бизнеса, подготовленный аналитическим центром TAdviser. Эксперты отметили компанию в категориях IaaS, SaaS и PaaS, подтвердив комплексность ее облачных решений. Провайдер Рег.облако вошел сразу в несколько рейтингов по ключевым моделям обслуживания, заняв 3 место в категории PaaS, 10 — в IaaS и 20 — в SaaS. Включение сразу по трем основным облачным моделям свидетельствует о способности Рег.облака предлагать клиентам комплексные решения: от базовой инфраструктуры до готовых отраслевых приложений и платформ для разработки. Аналитическое агентство отмечает рост зрелости российского облачного рынка и увеличение спроса на комплексные облачные решения со стороны бизнеса. Включение Рег.облака в отраслевой обзор подтверждает соответствие услуг компании высоким требованиям рынка и способность закрывать полный цикл задач клиентов — от предоставления базовой инфраструктуры до развернутых отраслевых программных продуктов. «Рег.облако укрепляет собственные позиции на рынке облачных услуг России в качестве надежного технологического партнера для цифровой трансформации бизнеса, — комментирует Сергей Рыжков, коммерческий директор Рег.облака. — Для нас важно предлагать клиентам не просто облачные сервисы, а целостную, безопасную и масштабируемую среду, которая позволяет компаниям быстро адаптироваться к изменениям и концентрироваться на своих ключевых задачах». Исследование TAdviser является авторитетным на российском IT-рынке, анализируя провайдеров по широкому спектру критериев, включая технологические возможности, функциональность сервисов, безопасность, финансовую устойчивость и клиентскую базу. Обзор традиционно служит ориентиром для российских предприятий при выборе надежных облачных провайдеров. Рег.ру представляет линейку онлайн-сервисов для продавцов на маркетплейсах Компания упростит вывод бизнеса в Ozon и Wildberries с новой линейкой продуктов бизнес-хаба Рег.решений для селлеров. Российская технологическая компания Рег.ру создала специализированную серию продуктов для предпринимателей, работающих или планирующих выйти на маркетплейсы. Новые решения призваны систематизировать процесс запуска и масштабирования онлайн-бизнеса на торговых площадках. www.reg.ru/solutions/catalog/marketplaces Продуктовая линейка Рег.решений для селлеров включает в себя три ключевых пакета услуг — «Быстрый старт на маркетплейсах», «Начинающий селлер» и «Продуктивный селлер», а также образовательный бизнес-тренажер в формате чат-бота. Решения отличаются по стадиям развития бизнеса: от выбора ниши и поиска поставщиков до аналитики, автоматизации процессов и диверсификации каналов продаж. Обучение в бизнес-тренажере построено на реальных кейсах и охватывает ключевые особенности вывода бизнеса на маркетплейсы. Участники получат доступ к видео с действующими успешными селлерами, изучат материалы по юнит-экономике, настройке личного кабинета, поиску товарной ниши и другим темам. С запуском новых сервисов для маркетплейсов Рег.ру закрывает ключевые боли селлеров: помогая новичкам избежать ошибок на старте, а опытным бизнесам — эффективнее масштабироваться, в том числе за счет запуска собственных онлайн-магазинов. «Основная проблема селлеров — отсутствие чистой прибыли. При медианной месячной выручке 53 тысячи рублей бизнес часто работает в ноль или даже в минус. Причина — непонимание специфики работы на маркетплейсах. Рег.решения помогут упростить этот процесс и оценить, подходит ли формат онлайн-торговли предпринимателю, прежде чем вкладываться в полноценный запуск», — отмечает Иван Грибов, директор по развитию продуктов для предпринимателей Рег.решения. Рег.решения объединяют продукты и услуги, которые эксперты подобрали под конкретные задачи малого бизнеса. С помощью Рег.решений можно самостоятельно запустить сайт, настроить продвижение и решить другие цифровые задачи, не обращаясь к подрядчикам. Сервис является собственной разработкой компании Рег.ру. На платформе доступно более 140 решений для разных отраслей и стадий развития бизнеса, свыше 20 встроенных партнерских сервисов, 55 экспертных материалов по частым запросам и несколько интенсивов по обучению предпринимателей...

Решение представляет собой программный аналог классических маршрутизаторов и предназначен для упрощения управления сетями. Российский провайдер Рег.облако интегрировал в облачную платформу виртуальные роутеры. Сервис позволяет настраивать маршрутизацию трафика между виртуальными машинами, организовывать связность в приватных сетях и подключать ресурсы к интернету через единый IP-адрес по технологии NAT (механизм преобразования IP-адресов). www.reg.cloud/cloud/servers Новый продукт работает как программный аналог классического маршрутизатора. Архитектура решения построена с акцентом на безопасность, предлагая встроенные механизмы для изоляции трафика и защиты данных. Программное решение Рег.облака поможет организовать изолированные среды для разработки и тестирования с выходом в интернет и подключать их к корпоративному контуру через защищенные соединения. Виртуальные роутеры позволяют создавать сложные сетевые конфигурации без покупки и обслуживания дорогостоящего «железного» оборудования. Решение не только более экономично, но и предоставляет гибкость для масштабирования сети под меняющиеся бизнес-задачи, что особенно актуально для компаний с развитой облачной инфраструктурой комментирует Алексей Тюняев, директор по облачным продуктам Рег.облака. С новым сервисом Рег.облака компании получат важный инструмент для управления всей облачной сетевой инфраструктурой. А создание безопасных приватных сетей в облаке поможет сотрудникам эффективнее работать, в том числе, с корпоративными ресурсами. Рег.облако признан одним из лидеров рынка облачных услуг в 2025 году Облачный провайдер Рег.облако вошел в топ-3 крупнейших поставщиков услуг PaaS по версии TAdviser Analytics. Рег.облако, российский поставщик облачных и bare-metal решений, включен в авторитетный обзор об облачных сервисах для бизнеса, подготовленный аналитическим центром TAdviser. Эксперты отметили компанию в категориях IaaS, SaaS и PaaS, подтвердив комплексность ее облачных решений. Провайдер Рег.облако вошел сразу в несколько рейтингов по ключевым моделям обслуживания, заняв 3 место в категории PaaS, 10 — в IaaS и 20 — в SaaS. Включение сразу по трем основным облачным моделям свидетельствует о способности Рег.облака предлагать клиентам комплексные решения: от базовой инфраструктуры до готовых отраслевых приложений и платформ для разработки. Аналитическое агентство отмечает рост зрелости российского облачного рынка и увеличение спроса на комплексные облачные решения со стороны бизнеса. Включение Рег.облака в отраслевой обзор подтверждает соответствие услуг компании высоким требованиям рынка и способность закрывать полный цикл задач клиентов — от предоставления базовой инфраструктуры до развернутых отраслевых программных продуктов. «Рег.облако укрепляет собственные позиции на рынке облачных услуг России в качестве надежного технологического партнера для цифровой трансформации бизнеса, — комментирует Сергей Рыжков, коммерческий директор Рег.облака. — Для нас важно предлагать клиентам не просто облачные сервисы, а целостную, безопасную и масштабируемую среду, которая позволяет компаниям быстро адаптироваться к изменениям и концентрироваться на своих ключевых задачах». Исследование TAdviser является авторитетным на российском IT-рынке, анализируя провайдеров по широкому спектру критериев, включая технологические возможности, функциональность сервисов, безопасность, финансовую устойчивость и клиентскую базу. Обзор традиционно служит ориентиром для российских предприятий при выборе надежных облачных провайдеров. Рег.ру представляет линейку онлайн-сервисов для продавцов на маркетплейсах Компания упростит вывод бизнеса в Ozon и Wildberries с новой линейкой продуктов бизнес-хаба Рег.решений для селлеров. Российская технологическая компания Рег.ру создала специализированную серию продуктов для предпринимателей, работающих или планирующих выйти на маркетплейсы. Новые решения призваны систематизировать процесс запуска и масштабирования онлайн-бизнеса на торговых площадках. www.reg.ru/solutions/catalog/marketplaces Продуктовая линейка Рег.решений для селлеров включает в себя три ключевых пакета услуг — «Быстрый старт на маркетплейсах», «Начинающий селлер» и «Продуктивный селлер», а также образовательный бизнес-тренажер в формате чат-бота. Решения отличаются по стадиям развития бизнеса: от выбора ниши и поиска поставщиков до аналитики, автоматизации процессов и диверсификации каналов продаж. Обучение в бизнес-тренажере построено на реальных кейсах и охватывает ключевые особенности вывода бизнеса на маркетплейсы. Участники получат доступ к видео с действующими успешными селлерами, изучат материалы по юнит-экономике, настройке личного кабинета, поиску товарной ниши и другим темам. С запуском новых сервисов для маркетплейсов Рег.ру закрывает ключевые боли селлеров: помогая новичкам избежать ошибок на старте, а опытным бизнесам — эффективнее масштабироваться, в том числе за счет запуска собственных онлайн-магазинов. «Основная проблема селлеров — отсутствие чистой прибыли. При медианной месячной выручке 53 тысячи рублей бизнес часто работает в ноль или даже в минус. Причина — непонимание специфики работы на маркетплейсах. Рег.решения помогут упростить этот процесс и оценить, подходит ли формат онлайн-торговли предпринимателю, прежде чем вкладываться в полноценный запуск», — отмечает Иван Грибов, директор по развитию продуктов для предпринимателей Рег.решения. Рег.решения объединяют продукты и услуги, которые эксперты подобрали под конкретные задачи малого бизнеса. С помощью Рег.решений можно самостоятельно запустить сайт, настроить продвижение и решить другие цифровые задачи, не обращаясь к подрядчикам. Сервис является собственной разработкой компании Рег.ру. На платформе доступно более 140 решений для разных отраслей и стадий развития бизнеса, свыше 20 встроенных партнерских сервисов, 55 экспертных материалов по частым запросам и несколько интенсивов по обучению предпринимателей...

Мы решили не ждать ноября и запускаем ранние скидки до 25% уже сейчас! Продлите или закажите услуги по самой выгодной цене — и получите гарантированные бонусы. Дополнительная скидка 10% распространяется на: заказ и продление хостинг-услуг,аренду виртуальных серверов (VPS) в России, Нидерландах, США, Израиле, Молдове, Армении, Турции, Германии, Франции, Гонконге,аренду выделенных серверов с каналом 10 Гбит/с.любые дополнительные услуги Акция действует с 23 по 31 октября 2025 года Скидка 10% + ваша стандартная скидка за продление = максимум выгоды Промокод: black-10-25 Количество промокодов ограничено — активируйте свой уже сегодня! webhost1.ru...

Мы решили не ждать ноября и запускаем ранние скидки до 25% уже сейчас! Продлите или закажите услуги по самой выгодной цене — и получите гарантированные бонусы. Дополнительная скидка 10% распространяется на: заказ и продление хостинг-услуг,аренду виртуальных серверов (VPS) в России, Нидерландах, США, Израиле, Молдове, Армении, Турции, Германии, Франции, Гонконге,аренду выделенных серверов с каналом 10 Гбит/с.любые дополнительные услуги Акция действует с 23 по 31 октября 2025 года Скидка 10% + ваша стандартная скидка за продление = максимум выгоды Промокод: black-10-25 Количество промокодов ограничено — активируйте свой уже сегодня! webhost1.ru...

Есть объективные факторы роста цен в ИТ — инфляция, кредитные ставки (их никто не снизил вслед за ставкой рефинансирования!), повышение страховых взносов для сотрудников и НДС. Как минимум это всё вместе уже обеспечит подорожание ИТ-услуг и инфраструктуры. И ещё есть субъективное ощущение, что в ИТ много денег и это что-то вроде новой нефтяной отрасли. А денег сейчас не хватает. Есть гипотеза, что сначала всех перепишут под льготы, а потом вместо льгот сначала переведут на общий режим, а затем и повысят налоговую нагрузку. Почему я так думаю — потому что у меня богатый опыт российского гражданина. И я уже вступил в реестр хостингов, который ни к чему не обязывал поначалу, но вот теперь это уже дорого и геморройно (но нужно). Вероятно, дальше будет ещё веселее. И у меня есть ощущение, что начало процесса мы уже наблюдаем по отмене части льгот для ИТ-компаний. Год назад я писал пост «Готовьтесь к росту цен», и так получилось, что в меня в профессиональной среде сначала кидались помидорами, потом начали цитировать, а потом текст скопировали для личных блогов от своего имени чуть ли не все топы сферы. Приятно, что мы запустили такую волну в рынок, но тема, конечно, печальная. Прошёл год, и пора снова посмотреть, что нас ждёт. Спойлер: вы, кажется, уже привыкли к плохим новостям, но жесть от этого никуда не делась. Общая ситуация Центробанк снизил ключевую ставку на 2% недавно. Кажется, должно стать легче? Ничего подобного. Реальная ставка по лизингу серверов для нас выросла на полпроцента в последнюю закупку. Мы работаем с крупными структурами, теми же операторами большой тройки, берём у них железо в рассрочку на 18 месяцев. Когда ставка ЦБ росла, их ставки тоже росли. Сейчас ставка ЦБ падает, а их — нет. Как была, так и осталась, от 35%. Даже немного выросла. На вопрос «почему?» ответ простой и обезоруживающий: — Потому что так, и всё. У нас внутренняя ставка такая. В смысле, что им банки не снижают ставку тоже. С банками история ещё веселее. У нас есть кредитная линия в крупном госбанке. Когда ставка ЦБ росла, они тут же присылали допсоглашение о повышении нашей ставки. Когда она начала падать, мы им позвонили с вопросом: — Ребят, а где пересчёт? Подешевело же! — Ну, вот видите, вот там в этом пункте написано, что у нас есть право, но не обязанность пересчитывать! Знаете, мы пока этим правом не воспользуемся. Этот паралич дорогих денег полностью заморозил рынок слияний и поглощений, которого мы ждали. Сделки идут, но под ковром. И они мучительно долгие: только чтобы получить Letter of Intent (предварительное соглашение), уходит 3–4 месяца. Вся сделка — это год. Крупный покупатель, которому тоже надо брать дорогой кредит, приходит к компании поменьше и говорит: «Мы вас покупаем за три копейки». А те отвечают: «Зачем? У нас хорошие показатели. Давайте подождём, ставки же начали снижаться». В итоге все чего-то ждут, а рынок стоит. Инвестиции пошли, мы даже видели пару публичных сделок и несколько, скажем так, закулисных. Но в целом там всё далеко не так активно, как я ждал. Золотая DDR4 Серверы за этот год подорожали на 5–15%. На 5% на DDR5, на 15% на DDR4! Основной вклад в рост цены дала именно память. DDR4 подорожала примерно на 50% с июня. Там получилось смешно. Производители, включая Samsung, решили свернуть её производство, переходя на DDR5. Но рынок оказался не готов — для DDR5 нужны новые материнские платы, а апгрейдить весь парк никто не спешит. В итоге возник дикий дефицит и цена на планки DDR4 с июня стала волшебной. Платиновая логистика Это просто ад. Свежая история: два сервера ехали из Китая в Армению. На границе их развернули, скорее всего, из-за ошибки в документах. Чтобы вернуть эти два сервера в Россию, переоформить и отправить заново, поставщик потратил почти 700 тысяч рублей. За два юнита! Почему так дорого? Потому что серверы возят морскими контейнерами, самолётами, ж/д, но большими партиями. Когда много единиц, растаможка бьётся на всех и получается недорого. А когда надо привезти два сервера, всё равно платишь за место, как будто везёшь огромную партию. Естественно, для поставщика эта сделка ушла в глубокий минус, а мы в очередной раз убедились, что эти риски закладываются в цену для всех. Таких ситуаций становится больше, поэтому сейчас либо надо возить большие партии, либо понимать, что в реле-странах могут быть проблемы. В итоге логистика уходит либо к крупным игрокам, либо становится ещё дороже. Налоги В прошлом году налоговая реформа уже подняла цены на 10–15%. В этом году нас ждёт продолжение банкета: Повышение НДС с 20 до 22%.Новые правила для «упрощёнки» (УСН), которые заставят наших поставщиков с оборотом от 60 млн платить НДС. Нюанс в том, что этот НДС нельзя принять к вычету — он мёртвым грузом ложится в цену.Страховые взносы для ИТ-компаний из реестра ПО повышают вдвое: с 7,6 до 15%.В сумме один только налоговый эффект даст на выходе ещё около 5% к цене. Но конкретно для нас главный фактор — новый реестр дата-центров. Мы думали, это для льгот на электричество. Вот здесь подробный рассказ про это явление. У меня ощущение, что как бы не так. Опыт подсказывает, что это очередное «узаконивание поборов». На недавнем саммите ЦОД все верещали: по их прогнозам, услуги дата-центров могут подорожать на 20–25%. Логика, видимо, такая: тарифы на электричество взвинтят для всех до небес, а ЦОДам из реестра дадут ставку, которая позволит им хотя бы не закрыться. В смысле, вероятно, вы теперь будете выключать свет в туалете, а ЦОДы получат льготы в виде неповышения цен на некоторое время. Если повезёт. Это стратегический разворот. Доходы от ресурсов упали, и государство ищет, чем их заменить. ИТ — единственная стабильно растущая отрасль. Я думаю, все льготы со временем уйдут, и нас будут доить, как раньше нефтянку. Искусственный интеллект расколол рынок Есть гиперскейлеры — Яндекс, Сбер, VK. Они могут позволить себе миллиардные инвестиции в AI-платформы. И есть все остальные. Проблема в том, что реального, массового запроса от бизнеса на эти сложные и дорогие AI-инструменты в России пока не видно. Россия в этом вопросе ровно посередине: колеблется, идти или не идти. Инструменты уже сделали, а кому их продавать — неясно. Если хайп не взлетит, для Яндекса это будут просто списанные убытки. Утрируя, ну повысят на 30 копеек стоимость вызова такси и за пару лет всё отобьют. А вот для компании поменьше, которая вложила кучу денег в железо, сделав неверную ставку на AI, это может стать фатальной ошибкой. Поэтому мы в эти большие игры пока не лезем. Слишком там хайпово. Итог Кредиты под 35%, дефицит ЦОДов (он всё ещё сохраняется, потому что при таких условиях их не строят, условно, выгоднее нести деньги в банк), подорожавшее на 15% железо, новые налоги, рост цен на электричество на 25% и кадровый голод, когда из 200 кандидатов подходит двое. Про кадры сильно легче не стало, кстати, разве что зарплаты ИТ-специалистов уже пару лет не растут, то есть, учитывая темпы инфляции, даже немного уменьшаются. В итоге мы снова выходим на прогноз роста цен на 10–15%. Выбор простой: экономить на качестве, закупая б/у железо, или повышать цены. Мы на качестве экономить не будем, шринкфляцией заниматься тоже. Так что, увы, готовимся. Относительно нас — в январе планируем повышение цен (около 5%). Как обычно, у нас можно оплатить заранее и надолго. При оплате на год скидка 20% + скидка Хабра, на полгода 10% + скидка Хабра. Если надо надолго по стабильной цене, то можно сразу несколько лет. Оплачивается не пополнение баланса на сумму, а именно период, то есть при изменении тарифа срок остаётся прежний. ruvds.com/ru-rub...

Есть объективные факторы роста цен в ИТ — инфляция, кредитные ставки (их никто не снизил вслед за ставкой рефинансирования!), повышение страховых взносов для сотрудников и НДС. Как минимум это всё вместе уже обеспечит подорожание ИТ-услуг и инфраструктуры. И ещё есть субъективное ощущение, что в ИТ много денег и это что-то вроде новой нефтяной отрасли. А денег сейчас не хватает. Есть гипотеза, что сначала всех перепишут под льготы, а потом вместо льгот сначала переведут на общий режим, а затем и повысят налоговую нагрузку. Почему я так думаю — потому что у меня богатый опыт российского гражданина. И я уже вступил в реестр хостингов, который ни к чему не обязывал поначалу, но вот теперь это уже дорого и геморройно (но нужно). Вероятно, дальше будет ещё веселее. И у меня есть ощущение, что начало процесса мы уже наблюдаем по отмене части льгот для ИТ-компаний. Год назад я писал пост «Готовьтесь к росту цен», и так получилось, что в меня в профессиональной среде сначала кидались помидорами, потом начали цитировать, а потом текст скопировали для личных блогов от своего имени чуть ли не все топы сферы. Приятно, что мы запустили такую волну в рынок, но тема, конечно, печальная. Прошёл год, и пора снова посмотреть, что нас ждёт. Спойлер: вы, кажется, уже привыкли к плохим новостям, но жесть от этого никуда не делась. Общая ситуация Центробанк снизил ключевую ставку на 2% недавно. Кажется, должно стать легче? Ничего подобного. Реальная ставка по лизингу серверов для нас выросла на полпроцента в последнюю закупку. Мы работаем с крупными структурами, теми же операторами большой тройки, берём у них железо в рассрочку на 18 месяцев. Когда ставка ЦБ росла, их ставки тоже росли. Сейчас ставка ЦБ падает, а их — нет. Как была, так и осталась, от 35%. Даже немного выросла. На вопрос «почему?» ответ простой и обезоруживающий: — Потому что так, и всё. У нас внутренняя ставка такая. В смысле, что им банки не снижают ставку тоже. С банками история ещё веселее. У нас есть кредитная линия в крупном госбанке. Когда ставка ЦБ росла, они тут же присылали допсоглашение о повышении нашей ставки. Когда она начала падать, мы им позвонили с вопросом: — Ребят, а где пересчёт? Подешевело же! — Ну, вот видите, вот там в этом пункте написано, что у нас есть право, но не обязанность пересчитывать! Знаете, мы пока этим правом не воспользуемся. Этот паралич дорогих денег полностью заморозил рынок слияний и поглощений, которого мы ждали. Сделки идут, но под ковром. И они мучительно долгие: только чтобы получить Letter of Intent (предварительное соглашение), уходит 3–4 месяца. Вся сделка — это год. Крупный покупатель, которому тоже надо брать дорогой кредит, приходит к компании поменьше и говорит: «Мы вас покупаем за три копейки». А те отвечают: «Зачем? У нас хорошие показатели. Давайте подождём, ставки же начали снижаться». В итоге все чего-то ждут, а рынок стоит. Инвестиции пошли, мы даже видели пару публичных сделок и несколько, скажем так, закулисных. Но в целом там всё далеко не так активно, как я ждал. Золотая DDR4 Серверы за этот год подорожали на 5–15%. На 5% на DDR5, на 15% на DDR4! Основной вклад в рост цены дала именно память. DDR4 подорожала примерно на 50% с июня. Там получилось смешно. Производители, включая Samsung, решили свернуть её производство, переходя на DDR5. Но рынок оказался не готов — для DDR5 нужны новые материнские платы, а апгрейдить весь парк никто не спешит. В итоге возник дикий дефицит и цена на планки DDR4 с июня стала волшебной. Платиновая логистика Это просто ад. Свежая история: два сервера ехали из Китая в Армению. На границе их развернули, скорее всего, из-за ошибки в документах. Чтобы вернуть эти два сервера в Россию, переоформить и отправить заново, поставщик потратил почти 700 тысяч рублей. За два юнита! Почему так дорого? Потому что серверы возят морскими контейнерами, самолётами, ж/д, но большими партиями. Когда много единиц, растаможка бьётся на всех и получается недорого. А когда надо привезти два сервера, всё равно платишь за место, как будто везёшь огромную партию. Естественно, для поставщика эта сделка ушла в глубокий минус, а мы в очередной раз убедились, что эти риски закладываются в цену для всех. Таких ситуаций становится больше, поэтому сейчас либо надо возить большие партии, либо понимать, что в реле-странах могут быть проблемы. В итоге логистика уходит либо к крупным игрокам, либо становится ещё дороже. Налоги В прошлом году налоговая реформа уже подняла цены на 10–15%. В этом году нас ждёт продолжение банкета: Повышение НДС с 20 до 22%.Новые правила для «упрощёнки» (УСН), которые заставят наших поставщиков с оборотом от 60 млн платить НДС. Нюанс в том, что этот НДС нельзя принять к вычету — он мёртвым грузом ложится в цену.Страховые взносы для ИТ-компаний из реестра ПО повышают вдвое: с 7,6 до 15%.В сумме один только налоговый эффект даст на выходе ещё около 5% к цене. Но конкретно для нас главный фактор — новый реестр дата-центров. Мы думали, это для льгот на электричество. Вот здесь подробный рассказ про это явление. У меня ощущение, что как бы не так. Опыт подсказывает, что это очередное «узаконивание поборов». На недавнем саммите ЦОД все верещали: по их прогнозам, услуги дата-центров могут подорожать на 20–25%. Логика, видимо, такая: тарифы на электричество взвинтят для всех до небес, а ЦОДам из реестра дадут ставку, которая позволит им хотя бы не закрыться. В смысле, вероятно, вы теперь будете выключать свет в туалете, а ЦОДы получат льготы в виде неповышения цен на некоторое время. Если повезёт. Это стратегический разворот. Доходы от ресурсов упали, и государство ищет, чем их заменить. ИТ — единственная стабильно растущая отрасль. Я думаю, все льготы со временем уйдут, и нас будут доить, как раньше нефтянку. Искусственный интеллект расколол рынок Есть гиперскейлеры — Яндекс, Сбер, VK. Они могут позволить себе миллиардные инвестиции в AI-платформы. И есть все остальные. Проблема в том, что реального, массового запроса от бизнеса на эти сложные и дорогие AI-инструменты в России пока не видно. Россия в этом вопросе ровно посередине: колеблется, идти или не идти. Инструменты уже сделали, а кому их продавать — неясно. Если хайп не взлетит, для Яндекса это будут просто списанные убытки. Утрируя, ну повысят на 30 копеек стоимость вызова такси и за пару лет всё отобьют. А вот для компании поменьше, которая вложила кучу денег в железо, сделав неверную ставку на AI, это может стать фатальной ошибкой. Поэтому мы в эти большие игры пока не лезем. Слишком там хайпово. Итог Кредиты под 35%, дефицит ЦОДов (он всё ещё сохраняется, потому что при таких условиях их не строят, условно, выгоднее нести деньги в банк), подорожавшее на 15% железо, новые налоги, рост цен на электричество на 25% и кадровый голод, когда из 200 кандидатов подходит двое. Про кадры сильно легче не стало, кстати, разве что зарплаты ИТ-специалистов уже пару лет не растут, то есть, учитывая темпы инфляции, даже немного уменьшаются. В итоге мы снова выходим на прогноз роста цен на 10–15%. Выбор простой: экономить на качестве, закупая б/у железо, или повышать цены. Мы на качестве экономить не будем, шринкфляцией заниматься тоже. Так что, увы, готовимся. Относительно нас — в январе планируем повышение цен (около 5%). Как обычно, у нас можно оплатить заранее и надолго. При оплате на год скидка 20% + скидка Хабра, на полгода 10% + скидка Хабра. Если надо надолго по стабильной цене, то можно сразу несколько лет. Оплачивается не пополнение баланса на сумму, а именно период, то есть при изменении тарифа срок остаётся прежний. ruvds.com/ru-rub...

C 1 ноября 2025 года Битрикс24 меняет условия продления лицензий для коробочной версии. Ранее продлить лицензию на выгодных условиях можно было без временных ограничений. Теперь воспользоваться скидкой 70% станет возможно только пока лицензия активна и в течение 15 дней после её окончания. По истечению срока придется оплачивать полную стоимость продления. Что делать? Следить за сроком действия лицензии. Своевременная оплата продления теперь играет ключевую роль. Проверьте, когда заканчивается лицензия, и обновите её заранее. Если срок вашей коробочной версии Битрикс24 закончился — успейте продлить её со скидкой до конца октября 2025, пока новые правила не вступили в силу...

C 1 ноября 2025 года Битрикс24 меняет условия продления лицензий для коробочной версии. Ранее продлить лицензию на выгодных условиях можно было без временных ограничений. Теперь воспользоваться скидкой 70% станет возможно только пока лицензия активна и в течение 15 дней после её окончания. По истечению срока придется оплачивать полную стоимость продления. Что делать? Следить за сроком действия лицензии. Своевременная оплата продления теперь играет ключевую роль. Проверьте, когда заканчивается лицензия, и обновите её заранее. Если срок вашей коробочной версии Битрикс24 закончился — успейте продлить её со скидкой до конца октября 2025, пока новые правила не вступили в силу...

Представляем OVHcloud Secret Manager — полностью управляемый сервис, который защищает ваши конфиденциальные данные (учётные данные, ключи API и т. д.) и гарантирует их защиту от кражи, подмены или потери. С Secret Manager вы можете безопасно хранить, управлять и использовать свои секреты в своих приложениях и/или сервисах OVHcloud. Основные преимущества Защитите ваши конфиденциальные данные от несанкционированного доступаБезопасно используйте свои секреты в собственных приложениях и/или сервисах OVHcloud.Контролируйте, автоматизируйте и регистрируйте весь доступ к вашим секретамОбеспечить соответствие нормативным требованиямПовышение безопасности и снижение риска Ключевые особенности Безопасное хранение секретов (учетных данных, ключей API и т. д.)Сертификации: FIPS 140-3, ISO 27001 (позже PCI-DSS, HDS и CSPN)Поддержка API: REST API и API, совместимый с Hashicorp Vault, для гибкой интеграции с различными приложениями и сервисами.Полностью управляемый интерфейс для безопасного управления секретамиКонтроль, автоматизация и протоколирование всех доступов к секретамВстроенная интеграция OVHcloud IAM для детального контроляЖурналы аудита в реальном времени и исторические журналы доступны через платформу данных журналов OVHcloudРаспространенные случаи использования Безопасное хранение и управление ключами API, учетными данными и другими конфиденциальными даннымиИнтеграция с конвейерами CI/CD и инструментами DevOpsСоблюдение требований к хранению и управлению конфиденциальными даннымиУведомление об истечении срока действия секрета Цены (после бета-фазы) OVHcloud Secret Manager предлагает предсказуемую и прозрачную модель ценообразования, независимо от того, какой объем секретов вы используете. Цена за секрет: € 0,03 / секрет / месяцЦена за запрос: добросовестное использование (порог будет подтвержден после бета-тестирования)

Представляем OVHcloud Secret Manager — полностью управляемый сервис, который защищает ваши конфиденциальные данные (учётные данные, ключи API и т. д.) и гарантирует их защиту от кражи, подмены или потери. С Secret Manager вы можете безопасно хранить, управлять и использовать свои секреты в своих приложениях и/или сервисах OVHcloud. Основные преимущества Защитите ваши конфиденциальные данные от несанкционированного доступаБезопасно используйте свои секреты в собственных приложениях и/или сервисах OVHcloud.Контролируйте, автоматизируйте и регистрируйте весь доступ к вашим секретамОбеспечить соответствие нормативным требованиямПовышение безопасности и снижение риска Ключевые особенности Безопасное хранение секретов (учетных данных, ключей API и т. д.)Сертификации: FIPS 140-3, ISO 27001 (позже PCI-DSS, HDS и CSPN)Поддержка API: REST API и API, совместимый с Hashicorp Vault, для гибкой интеграции с различными приложениями и сервисами.Полностью управляемый интерфейс для безопасного управления секретамиКонтроль, автоматизация и протоколирование всех доступов к секретамВстроенная интеграция OVHcloud IAM для детального контроляЖурналы аудита в реальном времени и исторические журналы доступны через платформу данных журналов OVHcloudРаспространенные случаи использования Безопасное хранение и управление ключами API, учетными данными и другими конфиденциальными даннымиИнтеграция с конвейерами CI/CD и инструментами DevOpsСоблюдение требований к хранению и управлению конфиденциальными даннымиУведомление об истечении срока действия секрета Цены (после бета-фазы) OVHcloud Secret Manager предлагает предсказуемую и прозрачную модель ценообразования, независимо от того, какой объем секретов вы используете. Цена за секрет: € 0,03 / секрет / месяцЦена за запрос: добросовестное использование (порог будет подтвержден после бета-тестирования)  ...

...

Мы завершили подключение к сети Piter-IX — одному из крупнейших точек обмена интернет-трафиком в Восточной Европе. Piter-IX объединяет сотни операторов, провайдеров и контент-сетей, обеспечивая прямой обмен данными между ними. Это снижает количество промежуточных маршрутов и уменьшает задержки при передаче информации. Благодаря переходу на Piter-IX клиенты ИХЦ получат: более быструю доставку контента за счёт прямых пиринговых соединений;меньше задержек и стабильную работу серверов даже при высокой нагрузке;повышенную отказоустойчивость инфраструктуры. Мы продолжаем развивать сетевую архитектуру ИХЦ, чтобы обеспечивать максимальную скорость, надёжность и комфорт для всех пользователей наших сервисов. ihc.ru...

Мы завершили подключение к сети Piter-IX — одному из крупнейших точек обмена интернет-трафиком в Восточной Европе. Piter-IX объединяет сотни операторов, провайдеров и контент-сетей, обеспечивая прямой обмен данными между ними. Это снижает количество промежуточных маршрутов и уменьшает задержки при передаче информации. Благодаря переходу на Piter-IX клиенты ИХЦ получат: более быструю доставку контента за счёт прямых пиринговых соединений;меньше задержек и стабильную работу серверов даже при высокой нагрузке;повышенную отказоустойчивость инфраструктуры. Мы продолжаем развивать сетевую архитектуру ИХЦ, чтобы обеспечивать максимальную скорость, надёжность и комфорт для всех пользователей наших сервисов. ihc.ru...

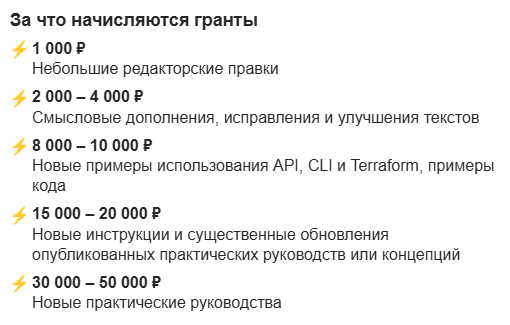

Используете облачные сервисы и готовы поделиться своими идеями? Станьте частью сообщества Yandex Cloud в рамках контент‑программы и получите грант до 50 000 рублей за ваш вклад в улучшение документации yandex.cloud/ru/content-program

Используете облачные сервисы и готовы поделиться своими идеями? Станьте частью сообщества Yandex Cloud в рамках контент‑программы и получите грант до 50 000 рублей за ваш вклад в улучшение документации yandex.cloud/ru/content-program  Чем весомее вклад, тем больше грантов вы получите! Нам важны любые ваши идеи и опыт работы с сервисами Yandex Cloud. Особенно мы ценим пошаговые руководства, которые помогают решать конкретные задачи. Если у вас есть интересные сценарии использования сервисов, поделитесь ими с другими пользователями. С чего начать? 1. Зарегистрируйтесь на GitHub github.com 2. Прочитайте соглашение с контрибьютором github.com/yandex-cloud/docs/blob/master/CONTRIBUTING.md 3. Изучите инструкцию по работе с репозиторием yandex-cloud/docs github.com/yandex-cloud/docs/blob/master/guides/how-to-contribute.md 4. Ознакомьтесь с руководствами по стилю и синтаксису Yandex Flavored Markdown (YFM). github.com/yandex-cloud/docs/blob/master/guides/how-to-write.md diplodoc.com/docs/ru/index-yfm Ждём ваших пул‑реквестов!...

Чем весомее вклад, тем больше грантов вы получите! Нам важны любые ваши идеи и опыт работы с сервисами Yandex Cloud. Особенно мы ценим пошаговые руководства, которые помогают решать конкретные задачи. Если у вас есть интересные сценарии использования сервисов, поделитесь ими с другими пользователями. С чего начать? 1. Зарегистрируйтесь на GitHub github.com 2. Прочитайте соглашение с контрибьютором github.com/yandex-cloud/docs/blob/master/CONTRIBUTING.md 3. Изучите инструкцию по работе с репозиторием yandex-cloud/docs github.com/yandex-cloud/docs/blob/master/guides/how-to-contribute.md 4. Ознакомьтесь с руководствами по стилю и синтаксису Yandex Flavored Markdown (YFM). github.com/yandex-cloud/docs/blob/master/guides/how-to-write.md diplodoc.com/docs/ru/index-yfm Ждём ваших пул‑реквестов!...

Привет, h3cloud! Возможно, вы помните, что в июне у нас была задержка из-за удачно сошедшегося ряда особенностей — переезда из ЦОДа Ростелекома, старого стека (при том, что на корпоративном проде частных облаков уже был новый) и потом задержек с развёртыванием сразу правильно. Завтра будет большой апдейт, и там новые полностью бесплатные пакеты для индивидуальных пользователей. По функционалу мы даем нашим пользователям, помимо виртуальных машин, виртуальные сети с преднастроенной конфигурацией, работающей из коробки и с большой гибкостью, чтобы настроить любые параметры, включая статическую маршрутизацию. Это, правда, открывает миллион способов выстрелить себе в ногу, если ты не знаешь, что делаешь, но ты получаешь полную свободу. Да, мы обновили цены, то есть демократичные цены на все предоставляемые нами ресурсы. Дальше мы… Конечно же, предоставляем широкий набор образов, включая образы на Windows. Правда, с опцией «Приноси свой ключ». Мы не забыли про базы данных, балансировщики, объектное хранилище, возможность делать бэкапы и снапшоты дисков. И, наконец-то, у нас доехал новый обновленный UI подо все это. Мы решили не мелочиться и для первых пользователей собрали пакет, на котором можно запустить серьёзный проект, а не только блог. Это не триальный «огрызок», а полноценный сетап. Что внутри: 2 мощные виртуальные машины (на свежих Xeon 5 с памятью DDR5).Балансировщик нагрузки, чтобы распределять трафик.Управляемая база данных (PostgreSQL или MariaDB на выбор).40 Гб быстрого сетевого хранилища (SSD).100 Гб объектного хранилища для файлов и бекапов.1 белый IPv4-адрес. Этого хватит, чтобы поднять сайт, который выдержит 10 тысяч запросов в секунду. Или развернуть корпоративную почту для всей компании. Ну или завести сервис наблюдения за котом. Можно даже за соседским, чтобы он у вас на участке не гадил. Сейчас заканчиваем стресс-тесты для инфраструктуры. Завтра откроем доступ уже в новой консоли. Посмотреть что у нас есть уже сейчас можно тут С уважением, Константин \m/ H3LLO.CLOUD...

Привет, h3cloud! Возможно, вы помните, что в июне у нас была задержка из-за удачно сошедшегося ряда особенностей — переезда из ЦОДа Ростелекома, старого стека (при том, что на корпоративном проде частных облаков уже был новый) и потом задержек с развёртыванием сразу правильно. Завтра будет большой апдейт, и там новые полностью бесплатные пакеты для индивидуальных пользователей. По функционалу мы даем нашим пользователям, помимо виртуальных машин, виртуальные сети с преднастроенной конфигурацией, работающей из коробки и с большой гибкостью, чтобы настроить любые параметры, включая статическую маршрутизацию. Это, правда, открывает миллион способов выстрелить себе в ногу, если ты не знаешь, что делаешь, но ты получаешь полную свободу. Да, мы обновили цены, то есть демократичные цены на все предоставляемые нами ресурсы. Дальше мы… Конечно же, предоставляем широкий набор образов, включая образы на Windows. Правда, с опцией «Приноси свой ключ». Мы не забыли про базы данных, балансировщики, объектное хранилище, возможность делать бэкапы и снапшоты дисков. И, наконец-то, у нас доехал новый обновленный UI подо все это. Мы решили не мелочиться и для первых пользователей собрали пакет, на котором можно запустить серьёзный проект, а не только блог. Это не триальный «огрызок», а полноценный сетап. Что внутри: 2 мощные виртуальные машины (на свежих Xeon 5 с памятью DDR5).Балансировщик нагрузки, чтобы распределять трафик.Управляемая база данных (PostgreSQL или MariaDB на выбор).40 Гб быстрого сетевого хранилища (SSD).100 Гб объектного хранилища для файлов и бекапов.1 белый IPv4-адрес. Этого хватит, чтобы поднять сайт, который выдержит 10 тысяч запросов в секунду. Или развернуть корпоративную почту для всей компании. Ну или завести сервис наблюдения за котом. Можно даже за соседским, чтобы он у вас на участке не гадил. Сейчас заканчиваем стресс-тесты для инфраструктуры. Завтра откроем доступ уже в новой консоли. Посмотреть что у нас есть уже сейчас можно тут С уважением, Константин \m/ H3LLO.CLOUD...